Installation simplifiée de Vaultwarden sur Debian avec APT

Un petit mémo sur l’installation de Vaultwarden sous Debian en utilisant le gestionnaire de paquet Apt.

L’utilisation du paquet Vaultwarden proposé via le dépôt communautaire vaultwarden-deb présente de nombreux avantages pour une installation sur Debian 12.

Cette méthode permet une mise en place rapide et propre grâce à l’intégration native dans le système APT : l’installation se fait en quelques commandes, et les futures mises à jour peuvent être appliquées automatiquement via apt upgrade.

Le service vaultwarden.service est également préconfiguré pour s’intégrer parfaitement à systemd, ce qui simplifie son démarrage, sa surveillance et sa gestion.

De plus, le web vault est déjà intégré, les fichiers de configuration sont centralisés dans /etc/vaultwarden.env, et aucun composant supplémentaire (comme Docker ou Rust) n’est requis.

Bien que ce dépôt ne soit pas officiel, il est activement maintenu par la communauté et constitue une solution fiable pour ceux qui souhaitent une instance Vaultwarden fonctionnelle, maintenable et bien intégrée à leur système Debian.

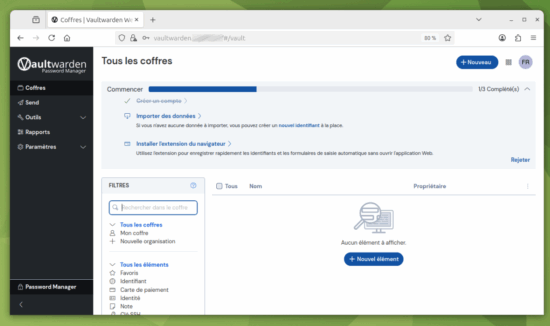

Vaultwarden

Vaultwarden est une alternative légère, auto-hébergeable et open source au gestionnaire de mots de passe Bitwarden. Écrit en Rust, il consomme peu de ressources tout en restant compatible avec les applications officielles Bitwarden (navigateur, desktop, CLI).

Il permet de stocker et partager en toute sécurité des identifiants, notes et secrets via une interface web moderne ou des clients natifs.

Idéal pour les petites équipes ou un usage personnel, Vaultwarden peut être déployé sans Docker et s’intègre facilement à un reverse proxy comme Nginx.

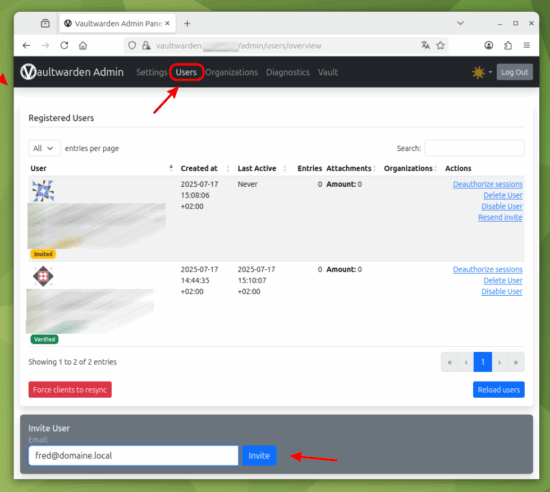

Installation de Vaultwarden

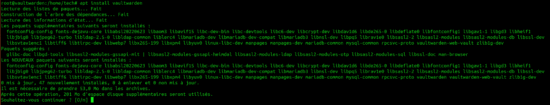

- Ajout du dépôt non officiel vaultwarden-deb et installation du paquet vaultwarden :

wget -qO- https://vaultwarden-deb.pages.dev/dists/bookworm/install.sh | sudo bash sudo apt update sudo apt install vaultwarden

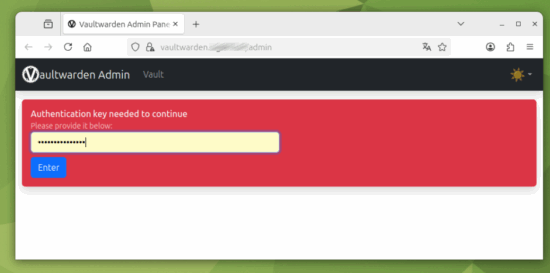

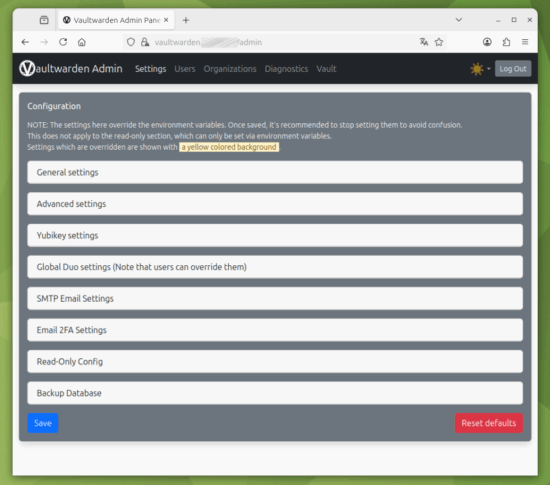

vaultwarden hash

/etc/vaultwarden.env :nano /etc/vaultwarden.env

ADMIN_TOKEN='$argon2id$v=19$m=65540,t=3,p=4$mD6bDLcfO6p3Hop0O8TFCfGMifdFK15IoPnEmuWMdKk$rVJzBHPHSBXGTCHSJIJSHGSHhW/6qon80m2xbxPB8fgmRQOHo'

systemctl restart vaultwarden

apt install nginx -y

mkdir -p /etc/nginx/ssl

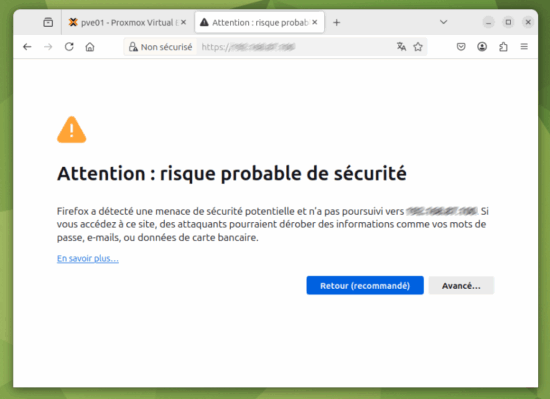

sudo openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /etc/nginx/ssl/vaultwarden.key -out /etc/nginx/ssl/vaultwarden.crt -subj "/C=FR/ST=Local/L=Local/O=LocalOrg/OU=Local/CN=vaultwarden.domaine.local"

cp /etc/nginx/ssl/vaultwarden.crt /usr/local/share/ca-certificates/vaultwarden.crt

update-ca-certificates

nano /etc/nginx/sites-enabled/vaultwarden

server {

listen 443 ssl;

server_name vaultwarden.domaine.local;

ssl_certificate /etc/nginx/ssl/vaultwarden.crt;

ssl_certificate_key /etc/nginx/ssl/vaultwarden.key;

location / {

proxy_pass http://127.0.0.1:8000; # Vaultwarden écoute en HTTP

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

}

}

# Rediriger le HTTP vers HTTPS

server {

listen 80;

server_name vaultwarden.domaine.local;

return 301 https://$host$request_uri;

}

nginx -t

systemctl restart nginx