Logiciels libres pour la comptabilité d'entreprise

Où l’on s’essaie à dresser un panorama des logiciels comptables libres. À l’origine de cette dépêche, une recherche d’un logiciel de paye libre où il a semblé que cela pouvait être utile.

Il s’agit bien de logiciels de comptabilité pour un usage professionnel ou associatif, pas de gestion de finances personnelles qui ont fait l’objet d’une autre dépêche il y a quelque temps. Évidemment, il n’y a aucune prétention à l’exhaustivité, mais plus à donner un panel de logiciels avec quelques idées pour choisir le vôtre, le cas échéant. N’hésitez pas à les essayer quand c’est possible et à croiser les informations pour vous faire votre opinion. Les fiches sont succinctes, mais c’est l’occasion pour vous d’écrire plein de nouvelles dépêches puisque la plupart de ces logiciels n’ont pas eu de présentations récentes sur LinuxFr.org.

Sommaire

- Compta.libremen.com

- Diacamma

- Dolibarr

- Ekyagri

- ENDI

- ERPNext / Dokos

- Frappebook

- Galette

- GnuCash

- Grisbi

- Laurux

- Ledger

- Noalyss (autrefois PHPCompta)

- Odoo

- OpenConcerto

- Paheko (ex Garradin)

- Tryton

- D’autres listes, d’autres articles

- Alors, un logiciel de comptabilité pour quoi faire ?

- Quel logiciel de comptabilité adopter ?

- La gestion de la paie

Entrons tout de suite dans le vif du sujet. Voici des courtes présentations avec des points forts et des points faibles qui se dégagent des expériences des rédacteurs et rédactrices. Pour vous aider à faire un choix, cette liste est suivie d’explications plus générales.

Compta.libremen.com

Compta libremen com est un logiciel de compta en partie double, simple et efficace. Il utilise une interface web sans fioritures. Le logiciel est écrit en Perl et s’appuie sur Postgresql et mod_Perl, avec un serveur Apache. Un fork amical fournit une image Docker et quelques améliorations. Libremen propose une offre en ligne.

Commentaires de l’auteur recueillis par courriel : on a un peu d’aide à la saisie, il y a les raccourcis claviers (calcul du numéro de pièce, recopie de la ligne précédente) et aussi les fenêtres déroulantes pour les numéros de compte, plus le fait que le navigateur enregistre les dernières saisies ; je crois avoir documenté toutes les fonctions, la documentation est dite “minimum”, le logiciel est minimaliste par essence, donc la doc aussi :-)

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | oui |

| Intègre | documents TVA, export FEC |

| Comptabilité | en partie double |

| Comptabilité analytique | oui, champ “Libre” |

| Imports | écritures en CSV |

| Exports | écritures en CSV |

| Transmission automatisée | non |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, minimum |

| Forum | non |

- Points forts : simple et efficace, raccourcis clavier, très léger, sans fioritures, quand on connaît la compta, on peut tout faire sans la souris, ça fonce, j’adore.

- Points faibles : comme les points forts, si vous n’y connaissez rien, ça peut-être intimidant.

- Licence : CeCILL-C

- Site : https://compta.libremen.com/

- Site du fork : https://github.com/picsou83/compta.libremen.com

Diacamma

Le logiciel existe en deux versions, Diacamma Asso pour les associations et Diacamma Syndic pour les copropriétés. Diacamma utilise une interface web, avec un serveur intégré. Un installeur est fourni pour Windows, macOSX et Linux (Debian conseillée). Le CHATONS Sleto propose une offre en ligne.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | non |

| Intègre | achats, ventes, factures, adhérents, documents et + |

| Comptabilité | en partie double |

| Comptabilité analytique | oui, simplifiée |

| Imports | écritures comptables, articles, contacts |

| Exports | écritures en CSV |

| Transmission automatisée | non |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | restreint aux connectés, gratuit |

- Points forts : le facturier qui permet aussi de faire des statistiques des ventes et d’éditer des factures et des reçus, le récapitulatif à gauche de l’écran, une vision comptable par « journaux auxiliaires ».

- Points faibles : les fenêtres modales pour les écritures, la saisie par « journal auxiliaire » qui alourdit le processus, le vocabulaire pas très adapté au secteur.

- Licence : GNU General Public License 3

- Site : https://www.diacamma.org/

Dolibarr

Dolibarr est un puissant ERP pour tous types d’entreprises et d’associations. Il existe des pré-sélections des modules nécessaires à votre activité. Dolibarr utilise une interface web avec des serveurs web et SQL. Un installeur est fourni pour Windows et des paquets pour plusieurs distributions Linux. Beaucoup d’offres d’hébergement existent. Il réunit une forte communauté, surtout francophone. Le développement est très actif.

Notez qu’on parle souvent de Dolibarr sur LinuxFr.org et qu’un journal sur une migration d’ERP a produit des interventions de haut niveau.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, adhérents, documents, stock, et plein d’autres |

| Comptabilité | simplifiée ou en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | des journaux, du Grand Livre, et des écritures sous différents formats |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : il est possible d’ajouter des extensions avec le magasin d’application, le dolistore. Dolibarr est également disponible chez certains hébergeurs à travers Softaculous. Une gestion fine des droits par groupe d’utilisateurs et par utilisateurs. Avec certains droits réservés aux utilisateurs internes c’est-à-dire ceux qui ne sont ni client ni fournisseur.

- Points faibles : l’aspect « usine à gaz » de Dolibarr et sa prise en main qui peut être ardue.

- Licence : GNU GPL V3 et plus

- Site : http://www.dolibarr.org

- Dolibarr sur LinuxFr.org.

Ekyagri

Une solution en ligne de gestion d’exploitation agricole.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : la facilité de la saisie des écritures, la gestion des immobilisations, sa conception bien pensée pour le secteur. L’aide est bien faite, elle indique notamment des niveaux de difficultés des tâches. On peut la télécharger au format PDF.

- Points faibles : le site n’est pas très clair sur la récupération des données. On n’a pas de module de recherche sur l’aide en ligne et rien n’est indiqué sur les sauvegardes.

- Licence : AGPL v3

- Site : https://ekylibre.com/ekyagri/

ENDI

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : la documentation complète

- Points faibles :

- Licence : GNU General Public Licence version 3

- Site : https://endi.coop/fonctionnalites

- Code source : https://framagit.org/endi/endi

ERPNext / Dokos

Un puissant ERP créé en Inde, le fork Dokos est la version française. Écrit en Python et JavaScript au-dessus d’une base Postgresql. Modulaire, il se positionne comme Odoo (voir ci-dessous). Comparons-les : l’interface est plus austère, la renommée moindre entraîne peu de contributeurs tiers à proposer des modules, l’équipe est plus petite, mais tout aussi dynamique, ERPNext évolue vite, il est basé sur le framework FRAPPÉ qui est stable et permet d’extraire les applications de l’ERP, l’ensemble est intégralement libre.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, documents, stock et plein d’autres modules |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | écritures en CSV |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : L’interface est uniformisée, ergonomique et soignée

- Points faibles : Tout ce blanc est un peu austère

- Licence : GNU General Public Licence version 3

- Site : https://erpnext.com/ et https://dokos.io/

- Code source : https://github.com/frappe/erpnext

Frappebook

Même équipe qu’ERPNext. C’est juste le morceau comptable d’ERPNext, refait en application de bureau et portable par dessus SQLite. Pour les petites entreprises.

- Points forts : Application portable, on peut l’emmener sur sa clef USB. L’interface est sobre et bien finie.

- Points faibles : au lancement on se retrouve dans une compta anglo-saxonne, il faut paramétrer pour avoir une compta “européenne”.

- Licence : GNU General Public Licence version 3

- Site : https://frappebooks.com/

- Code source : https://github.com/frappe/books

Galette

Sous le nom sympathique et tarabiscoté de Galette (Gestionnaire d’Adhérents en Ligne Extrêmement Tarabiscoté mais Tellement Efficace) se cache un logiciel à destination des associations.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, adhérents |

| Comptabilité | simplifiée ou en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : Il est très facile à prendre en main, en comptabilité simple ou double. Il y a une aide en ligne copieuse ainsi qu’une liste d’entraide. Le logiciel propose plusieurs plans comptables (Au moins deux pour les plans comptables français et d’autres pour la plupart des pays européens). On peut aussi ajouter son propre plan comptable. Il offre des fonctionnalités de comptabilité analytique. On peut utiliser sa propre instance, récupérer la base de données ou exporter la comptabilité sous divers formats (CSV, FEC, ODS et XLSX). Il est possible d’importer une comptabilité dans ces formats. Le logiciel est en constante évolution, avec un développeur très réactif. Des modules permettent de gérer aussi les paiements en ligne (puisque c’est aussi un logiciel de gestion de facturations et de clients). Il y a un module PdV (point de vente, caisse).

- Points faibles :

- Licence : GNU General Public Licence version 3

- Site : https://galette.eu/site/fr/

- Code source : https://github.com/galette/galette

- Galette sur linuxFr.org.

GnuCash

GnuCash figure dans la bibliothèque logicielle de la plupart des distributions Linux. C’est un logiciel qui fait aussi bien la comptabilité personnelle que la comptabilité professionnelle. Il propose des fonctionnalités de CRM de base : gestion des adresses des clients et des fournisseurs.

| Interface | Bureau (Gtk) |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : on peut paramétrer des écritures répétitives (paiements mensuels par exemple) et le logiciel vous le rappelle dans des délais fixés par vous à l’ouverture. Sa bibliothèque de rapports (ou états) est riche : bilan, comptes de résultat, portefeuille d’action, facture, quittance, graphiques. Et c’est personnalisable souvent. Les rapprochements bancaires se font avec pré-affectation des comptes grâce à de l’inférence bayésienne.

- Points faibles : Il n’y a pas de plan comptable intégré, il faut l’ajouter. Ni de fonctionnalité d’import d’un plan comptable (ou alors, je n’ai pas trouvé), pas de comptabilité analytique, non plus. Il n’est pas complètement traduit en français et la traduction est un peu étonnante parfois. La prise en main n’est pas évidente.

- Systèmes d’exploitation : Windows, MacOS, GNU/Linux, Unixes

- Interface : graphique

- Licence : GNU General Public License Version 2 ou Version 3

- Site : https://gnucash.org/

- Code source : https://sourceforge.net/projects/gnucash/

- GnuCash sur linuxFr.org (dépêches anciennes).

Grisbi

Un logiciel qui fonctionne tout seul et qui est souvent fourni dans les distributions Linux. Il est surtout utilisable pour les finances personnelles, mais il propose un mode comptabilité libérale et peut être utilisé par des micro-entreprises.

| Interface | Bureau (GTK-3) |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : il n’est pas compliqué à installer, on peut importer des fichiers au format CSV (évidemment) mais aussi aux formats QIF, OFX et Gnucash. Pour les rapprochements bancaires, soit dit en passant, choisir le format QIF c’est encore celui qui fait le mieux le travail. Et on peut l’exporter au format QIF ou CSV. Deux formats souvent utilisés par les logiciels de comptabilité. Il propose un pratique simulateur de crédit. Il est assez facile à prendre en main. Quand on fait un rapprochement bancaire, pour une comptabilité personnelle, en bout de course, on a une bonne partie des écritures comptables qui sont saisies.

- Points faibles : pas de comptabilité analytique, pas de compte de résultat ni de bilan et, évidemment, il n’est pas possible d’éditer des factures. L’interface GTK avait quelques bugs sous Windows (il y a plusieurs années, peut-être corrigés depuis), comme des menus déroulants qui empêchent de valider un formulaire tant qu’on a pas cliqué à côté pour les fermer.

- Logiciel inspiré de l’ex MsMoney (qui n’est plus vendu par Microsoft)

- Licence : GNU General Public License Version 2

- Site : https://fr.grisbi.org/

- Code source : https://github.com/grisbi/grisbi

- Grisbi sur LinuxFr.org.

Laurux

Laurux intègre les outils classiques de gestion d’entreprise : comptabilité, facturation, gestion de stock et tous les composants nécessaires aux prises de décisions cohérentes. Développé en Gambas avec Qt à destination des PME, son auteur a aussi voulu créer un logiciel simple d’installation et d’utilisation livré avec toute la documentation utile. L’auteur fournit une attestation individuelle de conformité, obligatoire dans la loi française. Son forum communautaire est accueillant.

| Interface | Bureau (Qt) |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, point de vente |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | plein de formats |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : Logiciel multiposte performant et fiable. Gestion de la compta, des stocks et achats/devis/factures très simples. Se prend en mains sans trop de complication. Et des développeurs présents, c’est hyper important de souligner le travail de Patrick et Damscot. Pour être plus large, j’ai, par le passé, utilisé Adicom, EBP, l’AS400 (une usine à gaz de fou ce logiciel), et un autre système dans le négoce également. Avec Laurux, je retrouve les avantages de l’AS400 sans avoir les complications d’utilisation.

- Points faibles :

- Licence : GNU General Public Licence version 3

- Site : https://www.laurux.fr/

-

Code source :

- https://github.com/PatrickMag/Laurux (la branche active est v3.69pat)

- https://github.com/damscot/Laurux

- Laurux sur LinuxFr.org.

Ledger

Ledger est un outil en ligne de commande, qu’on nourrit avec de simples fichiers textes. La puissance de la ligne de commande en fait tout l’intérêt. Développé en C++ il a été porté sur de nombreux autres langages. Ledger ne fait que la comptabilité en partie double. Plusieurs extensions facilitent son utilisation, sans entraver la rapidité de saisie.

| Interface | Console (terminal) |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : Adapté pour les compte-rendus, donc en complément d’un autre logiciel. Il est super puissant car facilement scriptable.

- Points faibles : Par contre, il a très peu de garde-fous. On peut mettre n’importe quelle transaction, il ne dira rien. J’avais dans l’idée de faire des scripts pour automatiser/sécuriser des transactions classiques (dépenses sur une clef, vente d’un lot, etc.) mais j’ai arrêté d’être syndic bénévole avant de le faire (marre de courir après les impayés d’un copropriétaire)

- Licence : BSD

- Site : https://www.ledger-cli.org/

- Code source : https://github.com/ledger/ledger

Noalyss (autrefois PHPCompta)

Au départ centré sur la compta, Noalyss est devenu un logiciel de gestion d’entreprise très complet. Noalyss utilise une interface web avec des serveurs web et Postgresql. Des paquets et une procédure d’installation existent pour Linux, Windows et MacOSX. Activement développé en Belgique, sa communauté importante est conviviale.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | ? |

| Intègre | achats, ventes, factures, stock, documents, etc. |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | ? |

| En réseau | oui, et aussi sur Internet |

| Aide | docu, wiki, tutos |

| Communauté | forum, liste |

- Points forts :

- Points faibles :

- Licence : GNU General Public Licence version 2

- Site : https://www.noalyss.eu/

- Code source : https://wiki.noalyss.eu/doku.php?id=developpement (plusieurs liens à partir de cette page)

- Noalyss sur LinuxFr.org.

Odoo

Odoo est un puissant ERP, modulaire, utilisé par des micro-entreprises comme des multinationales. L’entreprise Odoo connaît une croissance rapide depuis vingt ans, et emploie plus de 2000 personnes dans le monde. Le fondateur d’Odoo poste régulièrement des dépêches annonçant les nouvelles versions d’Odoo sur LinuxFr.org, et un journal sur une migration d’ERP a produit des interventions de haut niveau. Odoo est écrit en Python et utilise Postgresql, son interface est écrite en XML et Javascript. Il est facile à installer.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, stocks, documents et plein d’autres modules |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : L’interface est uniformisée, ergonomique et soignée. Le développement est intense depuis plus de vingt ans, appuyé sur l’entreprise Odoo et une large communauté d’intervenants et d’utilisateurs. Des milliers de modules sont disponibles. Documentation facile à lire, complétée par un forum et un grand nombre de sites, vidéos et livres. Énormément d’intégrations à des services d’État ou privés. La communauté s’est regroupée dans l’OCA Odoo Community Association qui maintient les anciennes versions et développe des centaines de modules libres de haute qualité. L’OCA propose aussi un outil de montée de versions.

- Points faibles : L’Apps Store Odoo est de qualité très diverse, certains modules ne sont pas libres, pour installer la comptabilité libre française, il faut s’y retrouver entre plusieurs modules. C’est plus simple pour les pays anglo-saxons.

- Licence : GNU General Public Licence version 3 et propriétaire

- Site : https://www.odoo.com

- Code source : https://github.com/odoo/odoo

- Odoo sur LinuxFr.org.

OpenConcerto

OpenConcerto est un progiciel de gestion intégrée (PGI ou ERP). Sa cible : les entreprises, grandes ou petites. C’est une application java à installer sur chaque poste utilisateur. Guillaume Maillard, son auteur, est un vieil habitué de LinuxFr.org.

| Interface | Bureau (version Web prévue en 2023) |

| Aide à la saisie | oui |

| Saisie au km | oui |

| Intègre | achats, ventes, factures, stock, paye, documents |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | FEC (DGFIP), EBP, Sage, Relation experts (Coala), Quadratus, Cegid CCMX |

| Transmission automatisée | SEPA |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : la comptabilité est facile à prendre en main. Il y a une version pour macOS (ce qui est à relever compte tenu de la rareté des logiciels comptables pour ce système d’exploitation). S’agissant d’un progiciel de gestion intégrée : il y a aussi des fonctionnalités de gestion commerciale, de suivi des stocks et de préparation des commandes. Plusieurs modules complémentaires existent comme un module d’OCR qui permet, à partir d’une facture numérisée, de la saisir automatiquement dans le logiciel, ou bien un module de paye (seul module payant) : fiches de paye, journaux de paye et déclarations.

- Points faibles : c’est très complet et donc un peu complexe pour une micro-entreprise. Certaines fonctionnalités manquent de clarté et d’exemples d’utilisation. La lecture du guide de démarrage ou du manuel (79€) est conseillée. L’équipe de développement manque de temps pour discuter sur les évolutions mais répond généralement aux questions qu’on lui pose sur le forum. Les données ne sont pas stockées de la même manière entre la version monoposte (un fichier H2) et multiposte (Postgresql). Bien choisir au début, sinon il sera difficile de changer.

- Licence : GNU General Public Licence version 3

- Site : https://www.openconcerto.org

- Code source : https://code.openconcerto.org/listing.php?repname=OpenConcerto

- OpenConcerto sur LinuxFr.org.

Paheko (ex Garradin)

Un logiciel principalement destiné aux associations, qui peut aussi être utilisé par des micro-entreprises. On l’utilise via un navigateur, il y a même une application pour mobile. C’est un logiciel complet de gestion d’association : membres, cotisation, comptabilité, communication.

| Interface | web |

| Aide à la saisie | oui |

| Saisie au km | |

| Intègre | achats, ventes, factures, |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | écritures comptables |

| Exports | |

| Transmission automatisée | |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui, complète |

| Forum | oui |

- Points forts : il est très facile à prendre en main, il y a une aide en ligne copieuse ainsi qu’une liste d’entraide. Le logiciel propose cinq plans comptables (associatif 1999 et 2018, Plan Comptable Général (PCG), Comités Sociaux et Économiques, copropriétés et plan comptable belge). On peut aussi ajouter son propre plan comptable. Il offre des fonctionnalités de comptabilité analytique. On peut utiliser sa propre instance, récupérer la base de données ou exporter la comptabilité sous divers formats (CSV, FEC, ODS et XLSX). Il est possible d’importer une comptabilité dans ces formats. Et, il est en constante évolution avec un développeur très réactif.

- Points faibles : pas de lettrage, pas de gestion directe des écritures périodiques.

- Licence : GNU Alfredo General Public Licence version 3

- Site : https://paheko.cloud

- Code source : https://fossil.kd2.org/paheko/doc/trunk/doc/index.md

- Paheko sur LinuxFr.org, cherchez aussi à Garradin.

Tryton

Tryton est un puissant ERP pour entreprises de toutes tailles. Il est accessible via un client Web, une application native ou bien une ligne de commande en Python. L’application cliente est dispo pour Windows, Mac et Linux, le serveur est empaqueté pour plusieurs distributions Linux. Comme Odoo dont il est un fork, Tryton est basé sur une architecture trois tiers écrite en Python (et un peu de ECMAScript version 6) avec PostgreSQL comme base de données. Les auteurs nous parlent régulièrement de Tryton sur LinuxFr.org.

| Interface | Bureau, Web, Console |

| Aide à la saisie | oui |

| Saisie au km | oui |

| Intègre | achats, ventes, factures, stock, projet, etc. |

| Comptabilité | en partie double |

| Comptabilité analytique | oui |

| Imports | CSV, AEB43, CODA, OFX ou CAMT.053 |

| Exports | FEC ou CSV |

| Transmission automatisée | Chorus, SEPA |

| En réseau | oui, et aussi sur Internet |

| Documentation | oui |

| Forum | oui |

- Points forts : L’interface est uniformisée, une fois comprise on s’y retrouve quel que soit le module. Un grand choix de modules permet de couvrir tout type d’activité. On peut tout paramétrer, ajouter des champs, en masquer, adapter des modules… Le développement est très actif, la fondation Tryton rassemble beaucoup d’entreprises et de projets, dont GNU Health. Les montées de version sont prises en charge automatiquement.

- Points faibles : L’interface est austère, il y a un très grand nombre d’options. C’est difficile à prendre en main sans être accompagné (mais c’est normal).

- Licence : GNU General Public Licence version 3

- Site : https://www.tryton.org/

- Code source : https://www.tryton.org/download#source

- Tryton sur LinuxFr.org.

D’autres listes, d’autres articles

Bien entendu, il manque plein de logiciels. On s’est limité à ceux qu’on a pu tester. Si ce petit résumé ne vous suffit pas ou n’est plus à jour, voici des sites avec des listes complémentaires (merci d’indiquer en commentaire si vous en connaissez d’autres).

- Les listes maintenues par l’April

- Sur Framalibre, le tag comptabilité

- Plain text accounting, comme son nom l’indique

- Après plusieurs mois d’enquêtes, de recueil d’avis et de tests, le journal en ligne Linux Weekly News (ou LWN.net) a fini par adopter GNUCash pour sa comptabilité en mai 2023. L’article est instructif : GNUCash n’est pas le choix parfait, mais pragmatique. Les articles précédents sur leur recherche sont consultables à partir de l’article.

- Sur Wikipédia Comparison of free and open source accounting software

Alors, un logiciel de comptabilité pour quoi faire ?

Avant tout pour faciliter la saisie comptable, fastidieuse quand elle est faite sur du papier (ou des tablettes de cire à l’origine !). Toutes les formes de comptabilité demandent une rigueur, des connaissances, du calcul et du temps — c’est un métier. Le logiciel comptable facilite tout ça.

Mais aussi pour l’automatisation du suivi comptable, c’est-à-dire la production automatique de synthèses lisibles et compréhensibles. Vous pensez peut-être au bilan, mais on a couramment besoin de consulter toutes les dépenses électriques ou toutes les recettes de pub sur LinuxFr.org. On a aussi besoin d’envoyer périodiquement ces synthèses à l’administration, comme la transmission des recettes de TVA.

Enfin, la comptabilité enregistre toutes sortes d’opérations, produites par d’autres logiciels spécialisés (salaires, fabrication, factures, etc.). Intégrer tout cela dans un même outil permet de gagner du temps et d’éviter les fautes de frappe (une facture génère automatiquement les écritures comptables correspondantes). Ça donne des logiciels plus ou moins touffus, certains intégrant toute la gestion d’entreprise, voire tous les outils de travail de l’entreprise — on les nomme ERP (ou PGI en français).

Note sur les ERP ou PGI

Quand SAP et les AS400 régnaient en maître sur ce domaine, les ERP étaient exclusivement de très gros logiciels intégrant non seulement la gestion et la comptabilité, mais aussi la production, la vente, le décisionnel, etc. La forte adaptation aux processus de l’entreprise via un paramétrage puissant, était leur gros atout et justifiait un coût d’installation très élevé. On en est même venu à appeler «SAP» ce type de logiciels.

La langue évoluant sans cesse, de nos jours on appelle ERP tout logiciel intégrant la gestion, le point de vente, la compta et deux trois outils de moindre importance, tandis qu’on les nommait autrefois «logiciels de gestion». Mais la puissance n’est pas la même (le besoin de formation non plus !). On a donc essayé de distinguer dans la liste un puissant ERP paramétrable et adaptable aux processus de l’entreprise, d’un logiciel intégrant les outils de gestion.

Quel logiciel de comptabilité adopter ?

Comme on va le voir, il y a beaucoup de critères, des vérifications, des questions à se poser. Les articles déjà mentionnés de LWN.net montrent assez bien les implications de vos choix. Si vous avez de quoi faire adapter l’outil à vos besoins, choisissez un ERP, puissant ou non.

Quel logiciel sélectionner pour sa comptabilité ? Ça dépend.

Ça dépend de votre statut fiscal, lequel est déterminé par votre chiffre d’affaires sauf dans certains cas précisés par la loi, et ça dépend si vous voyez la comptabilité comme un outil de gestion ou une obligation fiscale. Vous pouvez donc tenir une comptabilité pour des raisons fiscales, pour des raisons légales ou pour des raisons pratiques (ou les trois). Mais pour les mêmes raisons, vous pouvez tenir différentes formes de comptabilité :

- une comptabilité dite recettes-dépenses, semblable à votre budget familial, très courante dans les associations regroupant des bénévoles et ne vendant rien (un cahier suffit) ;

- une comptabilité simplifiée, dite de trésorerie, à peu près semblable à la première : vous classez les opérations bancaires, et vous rentrez les factures de vos fournisseurs, elle est classiquement permise par l’administration pour de faibles chiffres d’affaires ;

- une comptabilité en partie double, fiable et difficile, inventée par les marchands il y a quelques millénaires pour mieux gérer leurs entreprises ;

- une comptabilité analytique, qui complique les deux précédentes, mais permet de suivre très précisément les dépenses et recettes affectées à une opération, et perfectionne donc la gestion.

Sauf la première, ces comptabilités s’appuient sur une classification conventionnelle des opérations qu’on appelle le [plan comptable]]. Celui-ci varie selon les pays et votre statut juridique. L’utilisation du Plan comptable permet de produire les synthèses mentionnées plus haut — du calcul de la TVA au Bilan d’exercice.

Il y a des plans comptables tout prêts, adaptés à des activités particulières (comme les associations), mais tous dérivent d’un Plan comptable plus général. Votre logiciel doit permettre d’importer ou de créer le Plan comptable souhaité.

En passant, sachez qu’il y a des types de comptabilité, et que leur choix ne permet pas de suivre les mêmes choses. Par exemple, le monde anglo-saxon suit plutôt les finances tandis que le Vieux Continent suit plutôt les biens. Mais là, on rentre dans des débats de professionnels qu’il n’est pas nécessaire d’aborder, d’autant que les frontières (comptables) bougent en ce moment. Vérifiez ce qui est permis auprès de l’administration. Reposons notre question préalable en y répondant du point de vue pratique :

Quel logiciel sélectionner pour sa comptabilité ? Ça dépend. Bis.

Rappelons que beaucoup de logiciels ne se limitent pas à la comptabilité pure, mais intègrent d’autres outils utiles à la gestion (graphiques des recettes, gestion de cotisations, édition de factures, transmission automatisée aux administrations, etc.). Et attention, les écrans de saisie proposés dans les logiciels sont des aides dont un utilisateur expérimenté se passe très bien.

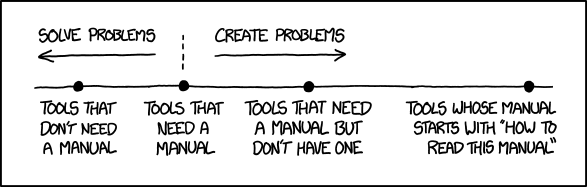

La comptabilité est une obligation, c’est peut-être obscur, fastidieux, vous la faites à reculons, mais la vie est ce qu’elle est, nous sommes dans le système, il faut donc y passer, chaque jour, semaine, année… Alors le meilleur choix, passe aussi par la facilité d’installation, les couleurs, la facilité de prise en main, etc.

Tout dépend donc surtout de vous :

- si vous avez besoin d’aides à la saisie ou non,

- si vous préférez des outils intégrés,

- si un outil intégré dédié à votre activité est un plus pour vous,

- si votre statut fiscal impose une compta en partie double,

- si vous la faites régulièrement pour la gestion de votre structure,

- si vous avez besoin d’exporter les données pour votre expert-comptable (vérifiez les formats possibles avec lui),

- si vous voulez un outil en réseau, voire en ligne sur internet,

- si vous avez déjà utilisé un logiciel et que vous vous y retrouvez.

NB Si qui peut le plus, peut le moins, sachez toutefois rester modestes si vous manquez de temps et de compétences, parce que les outils intégrés demandent une certaine maîtrise. Eh oui ! plus vous intégrez de trucs, plus il faut remplir et paramétrer les trucs avant d’utiliser la partie comptable. Par exemple, sur le cas simple d’une vente, avec un outil intégré il faudra avoir créé les produits, leurs taxes, le client, son bon de commande et les moyens de paiements avant d’attaquer la partie comptable.

Attention aux obligations fiscales françaises (utilisées lors d’un contrôle fiscal)

En application du 3° bis du I de l'article 286 du Code général des impôts (CGI), toute personne assujettie à la taxe sur la valeur ajoutée (TVA) qui effectue des livraisons de biens et des prestations de services à destination de clients particuliers et qui enregistre les règlements reçus en contrepartie au moyen d’un logiciel ou d’un système de caisse, est tenue d’utiliser un logiciel ou un système qui satisfasse aux conditions d’inaltérabilité, de sécurisation, de conservation et d’archivage des données en vue du contrôle de l’administration fiscale.

Tous les détails dans l’article du Bulletin Officiel des Finances Publiques - Impôts (BOFIP) TVA - Régimes d’imposition et obligations déclaratives et comptables - Obligations d’ordre comptable - Obligation d’utilisation de logiciels ou systèmes de caisse sécurisés

Format Fichier des Écritures Comptables (FEC)

Fichier texte tabulaire de 18 champs délimités par barres verticales ou par tabulations, ayant un nommage et un encodage précis ou éventuellement au format XML. Ce format est utilisé par la DGFiP pour pouvoir faire un contrôle automatisable de la comptabilité. Elle fournit un utilitaire de validation de format pour Windows.

Les points de vente

En France, la loi « anti-fraude » de 2016 et l’article 286 du Code des impôts imposent une certification des logiciels de caisse (c’est-à-dire des points de vente qui collectent des espèces) pour éviter les trucages de la comptabilité via modifications du code-source. Ah ben alors fini le libre ? Mais non mon bon, les logiciels libres sont autorisés, on en a beaucoup parlé sur LinuxFr.org. Toutes les structures n’y sont pas tenues, typiquement il faut être assujetti à la TVA.

NB Depuis la loi de finance 2018, article 105, les logiciels de comptabilité n’ont pas à être certifiés.

Si vous avez encore des doutes, consultez la FAQ en français facile écrite par l’équipe de Dolibarr.

La gestion de la paie

On n’en a pas beaucoup parlé alors que cette dépêche a commencé avec la recherche d’un logiciel de paie libre. Disons tout de suite qu’il est préférable de s’appuyer sur des professionnels, en effet la gestion de la paye repose sur trois piliers :

- la fiche de paie et les déclarations afférentes

- l’émission et la conservation sécurisée de la fiche de paie

- la saisie comptable

Certains logiciels ont des modules de gestion des payes (OpenConcerto pour la paie française, Odoo pour plusieurs pays…). L’avantage est de faciliter les écritures comptables. Mais attention, la gestion de la paye impose un suivi juridique et un suivi des taux des cotisations, car le cadre légal varie selon les professions, les salaires et varie aussi dans le temps. Cette actualisation permanente est faite par les professionnels (comptables et experts comptables). Sauf à bien connaître votre profession ou à être dans un cadre relativement simple (par exemple celui des intermittents du spectacle en France), vous gagnerez du temps, de l’argent et de la « légalité » en passant par des professionnels. Les options les plus courantes sont de choisir un cabinet d’expertise comptable ou un service en ligne (nettement moins cher). Lisez ou relisez les commentaires du forum.

S’agissant de la saisie et du traitement comptable de la paie, n’importe quel logiciel de comptabilité peut le faire, les logiciels de paye étant souvent susceptibles de mâcher le travail à ce niveau-là.

Commentaires : voir le flux Atom ouvrir dans le navigateur

Laisse-moi goûter à cette version !

Laisse-moi goûter à cette version !