Le développement de l’IA est-il compatible avec la protection de l’environnement. En l’état, on sait à force de d’études et de projections, que la réponse est négative.

Entre promesses d’innovation et réalité de l’empreinte carbone, Le Shift Project, aka « Le think tank de la décarbonation de l’économie », en remet une couche pour alerter sur une trajectoire insoutenable.

Selon son rapport * fraichement publié , les centres de données mondiaux suivent une trajectoire énergétique et climatique alarmante. Sans changement majeur, leurs émissions de gaz à effet de serre pourraient atteindre entre 630 et 920 MtCO₂e en 2030, soit jusqu’à deux fois les émissions totales de la France. Cette augmentation représenterait 2,5 fois les émissions de 2020, avec un taux de croissance annuel de 9%.

La consommation électrique des centres de données est passée de 120 TWh en 2005 à 420 TWh en 2024. Les projections indiquent qu’elle pourrait atteindre 1 250 à 1 500 TWh en 2030, soit une multiplication par 2,3 à 2,8 en sept ans.

Une croissance accélérée qui rend caduque l’objectif climatique affiché par du secteur : une réduction de 45% des émissions entre 2020 et 2030.

L’IA générative, moteur principal de la demande

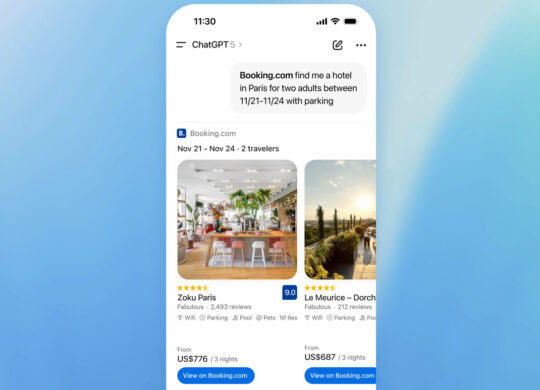

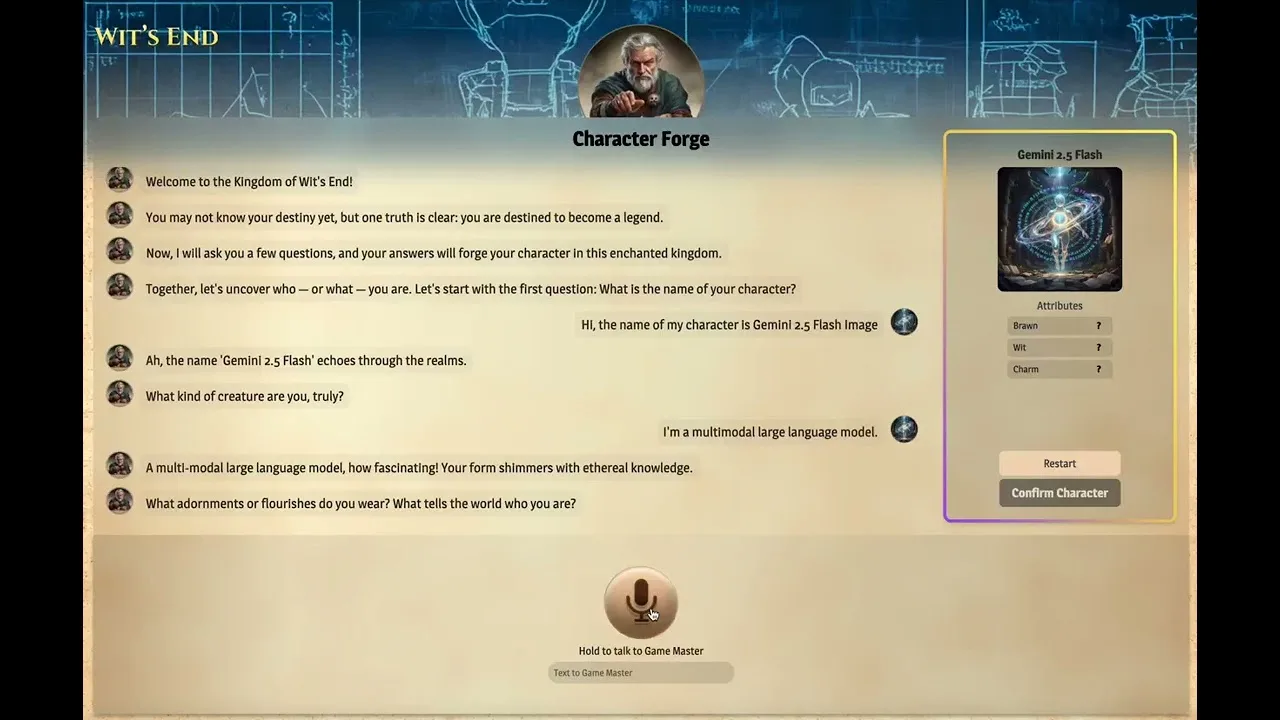

L’l’IA générative est le facteur déterminant de cette explosion énergétique. Entre 2025 et 2030, elle pourrait représenter jusqu’à 94% de la consommation électrique de l’IA, contre 62% en 2025. La phase d’inférence (utilisation des modèles) compte pour 47 points de cette augmentation.

Selon les données du Shift Project, les modèles d’IA générative consomment entre 50 et 25 000 fois plus d’énergie que les modèles d’apprentissage traditionnels pour une tâche équivalente. Par exemple, la génération d’images nécessite 50 à 100 fois plus d’énergie que la génération de texte.

Un recours massif aux énergies fossiles

Face à la rapidité de la demande, les acteurs de l’IA – éditeurs de LLM et fournisseurs d’infrastructures – se tournent vers les combustibles fossiles. Aux États-Unis, 85 installations de production d’électricité au gaz sont en développement pour les centres de données. Le centre Colossus de xAI dispose de 400 MW de générateurs au gaz naturel, tandis que Meta prévoit trois centrales à gaz totalisant 2,3 GW.

Les réseaux électriques du sud-est des États-Unis planifient l’ajout de 20 GW de capacités au gaz naturel, représentant jusqu’à 80 MtCO₂e d’émissions annuelles. Entre 2024 et 2030, l’Agence internationale de l’énergie estime que 3,3 GW de gaz et 1,5 GW de charbon seront ajoutés annuellement pour alimenter les centres de données.

L’Europe et la France sous pression

En Europe, la consommation électrique des centres de données pourrait passer de 97 TWh en 2023 à 165-200 TWh en 2030, représentant environ 7,5% de la production d’électricité européenne en 2035. Cette augmentation de plus de 200 TWh équivaut à la moitié de la réduction prévue de la production d’électricité à partir de gaz.

L’Irlande illustre concrètement cette tension : les centres de données y consomment déjà plus de 20% de l’électricité disponible, dépassant la consommation résidentielle urbaine. En 2021, le gestionnaire de réseau EirGrid a annoncé un moratoire de facto sur les nouvelles implantations jusqu’en 2028 dans la région de Dublin.

En France, RTE a identifié 25,5 GW de demandes en cours d’instruction pour des centres de données, dont 10 GW au stade de proposition technique. La consommation pourrait atteindre 33 à 45 TWh en 2035, soit 5,5 à 7,5% de la consommation électrique nationale projetée. Cette augmentation représenterait entre 15% et 23% de l’électricité supplémentaire prévue pour l’ensemble des usages.

Des impacts locaux multiples

Au-delà de l’énergie, les centres de données exercent une pression sur les ressources en eau. Selon Nature Finance, 45% des centres de données mondiaux sont situés dans des bassins fluviaux où la disponibilité de l’eau présente un risque élevé. À Marseille, certains centres utilisent de l’eau potable pour le refroidissement via le système de « river-cooling ».

L’empreinte carbone de la fabrication représente environ 25% de l’impact total des centres de données au niveau mondial. Pour les serveurs accélérés dédiés à l’IA, les composants électroniques (mémoire, processeurs, circuits intégrés) constituent entre 70% et 90% de l’empreinte carbone de fabrication. Cette proportion augmente avec la décarbonation de l’électricité.

Une absence de trajectoire de décarbonation

Pour respecter l’objectif d’une réduction de 90% des émissions entre 2020 et 2050, la consommation des centres de données en France devrait être limitée à environ 40 TWh en 2050, selon le rapport. Or, les tendances actuelles prévoient un dépassement de ce seuil dès 2035.

Le Shift Project identifie un plafond de consommation électrique au-delà duquel les objectifs climatiques deviennent inatteignables. Dans un scénario optimiste de décarbonation énergétique, ce plafond se situe autour de 950 TWh au niveau mondial en 2050. Dans un scénario moins favorable, il descendrait à 200 TWh.

Mais le secteur manque actuellement de mécanismes de pilotage. L’absence d’objectifs carbone contraignants pour la filière, le manque de transparence sur les consommations réelles et les délais de construction (6 mois à 5 ans) figent les capacités bien avant leur utilisation effective.

Recommandations pour une transition maîtrisée

Le Shift Project formule vingt recommandations structurées autour de quatre axes. Sur la transparence, il préconise un suivi public trimestriel des consommations et des demandes de raccordement, ainsi que l’obligation pour les fournisseurs de communiquer l’empreinte énergétique de leurs services.

En matière d’optimisation, le rapport recommande de privilégier les IA spécialisées plutôt que généralistes, et de concentrer la recherche sur des solutions efficaces et peu gourmandes en ressources. Le référentiel AFNOR pour l’IA frugale, présenté en septembre dernier, devrait être intégré aux politiques d’achat public.

Sur la sobriété, le rapport appelle à construire une trajectoire contraignante pour le numérique dans la stratégie nationale bas-carbone (la feuille de route de la France pour lutter contre le changement climatique), avec des plafonds de ressources consommables. Le déploiement de nouveaux centres devrait être conditionné à la compatibilité avec cette trajectoire, avec possibilité de moratoires en cas de dérive.

Enfin, sur la formation, le rapport insiste sur le maintien des ressources dédiées aux enjeux énergie-climat, sans les réorienter vers des formations sur l’IA. Un débat public informé sur la place du numérique dans la société doit être organisé, impliquant l’ensemble des parties prenantes.

Conclusion du Shift Project : l’ampleur des transformations nécessaires impose de mobiliser simultanément les leviers technologiques, organisationnels et politiques. Sans cette approche systémique, les objectifs de décarbonation resteront hors d’atteinte.

* Rapport : Intelligence artificielle, données, calculs – quelles infrastructures dans un monde décarboné ?