Ce nouveau matériau promet de donner un gros coup d'accélérateur à l'IA

La mise à jour de la rework Control a introduit une devise vitale dans Blox Fruits : les Données de Simulation. Cette devise est cruciale pour élever votre expérience de jeu à un niveau supérieur. Contrairement à d’autres devises, obtenir des Données de Simulation nécessite des méthodes spécifiques, que je vais décrire dans ce guide. […]

Le post Guide ultime : comment obtenir des données de simulation dans Blox Fruits est apparu en premier sur Moyens I/O.

Après le ministère de l’Intérieur, c’est au tour du ministère des Sports en France de faire l’objet d’un piratage. Il annonce que les hackers ont pu collecter les données de 3,5 millions de foyers. Et maintenant le piratage du ministère des Sports Dans un communiqué de presse, le ministère …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Le ministère des Sports a été piraté : les données de 3,5 millions de foyers volées est apparu en premier sur KultureGeek.

Dans la nuit du 17 au 18 décembre 2025, une publication sur un site du dark web a retenu l’attention de la communauté cyber. Un hacker affirme avoir dérobé un fichier contenant plus de 22 millions de lignes d’informations personnelles appartenant à la CAF. Contacté par Numerama, l'organisme tempère ces affirmations et indique qu’à ce stade, l’investigation en cours ne confirme pas d’intrusion directe dans ses systèmes d’information.

Le groupe de hackers Indra a publié sur BreachForums une base de données massive de la Caisse des Allocations Familiales (CAF) à la suite d’un piratage. Cette cyberattaque, revendiquée comme un « cadeau de Noël pour la France » par les pirates, expose les informations personnelles de millions …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article La CAF encore piratée, les données de millions de Français ont fuité est apparu en premier sur KultureGeek.

Si vous êtes comme moi, chaque fin d’année, vous faites peut-être le ménage dans vos mails, vos dossiers, parfois dans la vie pro. Mais le vrai bazar ne se trouve plus dans nos tiroirs : il est éparpillé dans des centaines de bases de données commerciales, de sites de recherche de personnes et de courtiers en données qui vendent notre profil en kit. Ces entreprises savent où vous habitez, ce que vous achetez, avec qui vous vivez, vos revenus probables, vos centres d’intérêt, parfois même votre état de santé supposé. Incogni s’attaque précisément à ce chantier invisible : faire supprimer, légalement et en continu, ces informations là où elles valent le plus pour les autres… et le moins pour vous.

Les « data brokers » vivent d’un modèle simple : collecter le maximum d’informations sur vous, les recouper puis les revendre à des publicitaires, assureurs, chasseurs de têtes, agrégateurs de profils, voire des acteurs beaucoup moins recommandables. Ils se nourrissent de formulaires, programmes de fidélité, applis, jeux « gratuits », cookies, traqueurs, fuites de sites, réseaux sociaux, etc. Une fois votre profil créé, il se duplique et se revend en boucle. Le résultat, ce sont des pubs ultra ciblées, des spams de plus en plus crédibles, une augmentation des risques d’usurpation d’identité, et la sensation désagréable d’être constamment suivi, même hors ligne. Bref c'est bien relou.

Le passage à 2026 est un moment idéal pour reprendre la main, parce que la tendance ne va pas s’inverser spontanément. Encore moins à l'époque de l'IA omniprésente. Plus on attend, plus votre « clone » numérique prend de la valeur (à chaque nouvelle information ajoutée) et plus il se multiplie. L’enjeu n’est pas de disparaître à 100% (ça c'est probablement mission impossible), mais de réduire la surface d’attaque : moins de données en circulation, moins de points d’entrée pour les arnaques, les hausses de tarifs ciblées, les fuites massives. Incogni propose d’industrialiser ce ménage, là où le faire à la main demanderait des centaines d’heures et une patience hors-norme.

L’idée d’Incogni est brutale dans le bon sens du terme : plutôt que de vous fournir des conseils abstraits, le service va directement chercher vos données chez plus de 420 courtiers et sites spécialisés, puis leur envoie des demandes de suppression en s’appuyant sur les lois en vigueur (RGPD en Europe, CCPA en Californie, PIPEDA si vous êtes au Canada, etc.). Dès l’inscription, le robot lance une première vague de requêtes, puis relance automatiquement tous les acteurs qui prennent trop leur temps. Des rapports réguliers indiquent qui a répondu, ce qui a été supprimé, ce qui est en cours, et ce qui résiste encore.

Pour l’utilisateur, tout se concentre dans un tableau de bord : on y voit les brokers contactés, le type de données qu’ils exploitent, et le statut de chaque requête (suppression confirmée, en attente, refus, relance planifiée). Les plans les plus complets ajoutent la possibilité de soumettre des demandes personnalisées sur des sites précis exposant vos infos : un vieux forum, un annuaire obscur, une base d’anciens clients, etc. Dans ces cas-là, l’équipe d’Incogni prend le relais et gère la procédure à votre place. C’est cette automatisation et ce suivi sur la durée qui font la différence avec un « grand ménage » ponctuel.

Incogni publie régulièrement des études sur la façon dont les gens laissent filer leurs données, notamment autour de périodes comme le Black Friday qui vient de se terminer. Une enquête récente menée aux États-Unis montre, par exemple, que les consommateurs sont nombreux à multiplier les comptes, newsletters et inscriptions « juste pour une promo », sans réfléchir à ce que deviennent leurs informations après coup. Beaucoup sous-estiment totalement le nombre de bases dans lesquelles leurs données terminent, et la durée pendant laquelle elles y restent. Certes, c’est basé sur des comportements américains, mais il n’y a aucune raison de penser que les Français, qui raffolent tout autant des bons plans et des achats en ligne, soient fondamentalement différents dans ce domaine.

Cette étude met surtout en lumière un paradoxe : les gens disent être inquiets pour leur vie privée… mais acceptent sans sourciller des conditions d’utilisation qui autorisent les marchands à revendre leurs infos. Fin 2025 / début 2026, c’est donc une fenêtre parfaite pour briser ce cercle. Après une année de formulaires, de comptes créés « juste pour voir », d’abonnements, d’inscriptions à des loteries en ligne, commencer 2026 en nettoyant tout ce qui peut l’être est un geste à la fois symbolique et très concret. Incogni se positionne précisément comme ce bouton « reset » annuel, voire permanent.

Une des forces d’Incogni , c’est d’être pensé aussi bien pour le particulier qui en a assez de voir son nom sur des sites de recherche de personnes, que pour la petite boîte qui doit prouver qu’elle prend la protection des données au sérieux. En entreprise, le service peut contribuer à limiter les risques de fuite de fichiers clients ou d’employés utilisés en dehors du cadre initial, tout en fournissant des rapports utiles pour les audits internes ou les échanges avec la CNIL & Co. Dans l’e‑commerce, la santé ou les services financiers, réduire ce qui traîne chez les courtiers, c’est aussi limiter l’ampleur possible d’un futur incident.

Du côté des particuliers, l’intérêt est plus instinctif : moins de spam personnalisé, moins de démarchage ciblé, moins d'appels non sollicités, moins de chances que des informations sensibles (adresse, date de naissance, numéros de téléphone, données de localisation, historique d’achat) servent à monter un dossier d’usurpation d’identité ou de scam bien ficelé. L’inscription est rapide, la prise en main se fait en quelques minutes, et les premiers résultats se voient souvent sous quelques semaines (baisse de certains spams, disparition progressive de fiches sur des sites de recherche de personnes). Certaines évaluations indépendantes mentionnent même des vérifications externes (type audit Deloitte) des cycles de relance et des promesses de suppression.

Le piège, ce serait de penser qu’un gros nettoyage une fois suffit. Les data brokers continuent d’aspirer en permanence des flux venant de nouvelles sources, de nouveaux partenaires, de nouveaux formulaires. C’est pour cela qu’Incogni fonctionne plutôt comme un abonnement qu’un simple « passage unique » : le service renvoie régulièrement des demandes, vérifie que les suppressions tiennent dans le temps, et ajoute à sa liste de nouveaux courtiers au fil des mois (des dizaines supplémentaires par an, selon les retours récents). L’objectif est de maintenir votre exposition à un niveau minimum, malgré la tendance inverse du marché.

Le début 2026 est un excellent prétexte pour enclencher cette logique. Faire son bilan de l’année, nettoyer ses comptes, resserrer ses mots de passe, activer un gestionnaire , et, en parallèle, lâcher Incogni sur les courtiers en données pour qu’il fasse le travail ingrat. Le combo est simple : vous limitez ce que vous donnez à l’avenir, et un service automatisé retire ce qui traîne déjà dans la nature. Ce n’est pas de la parano, c’est de l’hygiène numérique, au même titre qu’un antivirus ou un VPN. Surfshark propose d'ailleurs le triple combo dans son offre Surfshark One .

On ne récupérera sans doute jamais un contrôle absolu sur toutes les miettes laissées au fil des années. Mais réduire le volume de données exploitables, c’est déjà reprendre l’avantage. Et si un outil peut passer ses journées à harceler les courtiers en votre nom, autant le laisser faire pendant que vous vous occupez de choses plus intéressantes que de lire des politiques de confidentialité en petits caractères (vous pouvez me préparer du pain d'épice et me l'envoyer pour mes fêtes par exemple, au hasard).

Vous avez encore quelques jours pour profiter de l'offre de fin d'année à -55%, donc ne tardez pas trop. L'abonnement standard annuel revient à 86,26€ TTC, mais en appliquant le code KORBEN55 vous économisez encore un peu plus, puisque vous ne payerez que 77,63€ TTC.

Il y a du mouvement concernant le piratage du ministère de l’Intérieur, avec l’annonce ce soir de l’arrestation à Limoges d’un suspect de 22 ans, accusé d’être le hacker responsable de la cyberattaque. Un suspect de 22 ans a été arrêté « Le suspect, né en 2003, est déjà …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Piratage du ministère de l’Intérieur : un suspect a été arrêté est apparu en premier sur KultureGeek.

Les chercheurs en cybersécurité de l’entreprise KOI mettent en lumière un vaste et sournois réseau de revente de données. Ce système repose sur plusieurs extensions de navigateur, téléchargées des millions de fois et arborant les certifications les plus prestigieuses.

Vous aussi vous avez ce truc où vous devez juste faire un petit SELECT rapide sur votre base de données, et là vous lancez un monstre du genre SQL Server Management Studio ou DBeaver, vous attendez que ça se charge pendant 47 ans, que ça bouffe les 2 Go de RAM qu'il vous reste, et tout ça pour une requête de 3 lignes ?

Moi ça m'énerve profondément, j'avoue... Pas le temps, pas la patience !

Heureusement, y'a un dev qui en a eu encore plus marre que moi et qui a pondu sqlit . C'est une interface TUI (Terminal User Interface, je précise...) qui tourne direct dans votre terminal et qui supporte un paquet de bases de données différentes telles que PostgreSQL, MySQL, SQL Server, SQLite, MariaDB, Oracle, DuckDB, CockroachDB, Supabase, Turso... La liste est longue mais en gros, si ça parle SQL, sqlit sait s'y connecter.

Le truc est inspiré de lazygit , un client Git en TUI que beaucoup de devs adorent, ce qui fait qu'on retrouve cette approche "lazy" où l'interface se suffit à elle-même. Comme ça y'a pas besoin de mémoriser 150 raccourcis clavier, puidqu'il y a une aide contextuelle qui s'affiche et qui vous dit quoi faire, comme votre maman quand vous ne l'avez absolument pas sollicitée.

On a donc de l'autocomplétion SQL qui va chercher les noms de tables et de colonnes, un historique des requêtes par connexion (pratique pour retrouver cette requête chelou qu'on avait bidouillée y'a 3 semaines), et même la gestion des tunnels SSH intégrée pour se connecter à des bases distantes. Les utilisateurs de Vim seront contents aussi, car y'a un mode d'édition modal pour naviguer comme dans votre éditeur préféré.

Pour l'installer, c'est hyper simple :

pip install sqlit-tui

Et après vous tapez sqlit dans votre terminal et c'est parti. Les drivers pour chaque type de base de données s'installent à la demande la première fois que vous essayez de vous connecter. Donc pas de dépendances inutiles qui traînent si vous utilisez juste PostgreSQL par exemple.

Y'a aussi un mode CLI si vous voulez scripter vos requêtes :

sqlit query -c "MaConnexion" -q "SELECT * FROM Users" --format csv

Le seul truc naze je trouve, c'est le nom "sqlit" qui ressemble trop à SQLite. Bon courage pour googler des infos dessus... Je sais de quoi je parle, toutes les 2 semaines, y'a une entreprise Korben qui pop en voulant surfer sur mon buzz (ouais j'ai le melon, mdr) et qui passe toutes ses levées de fonds en adwords pour se positionner avant moi sur Google ^^. C'est couillon ^^.

Bref, si vous vivez dans le terminal et que vous en avez marre de lancer des client lourds juste pour un SELECT, c'est vraiment pratique.

Chez les principaux fournisseurs de bases de données cloud, il n’est plus si rare que des produits se chevauchent.

La synthèse du dernier Magic Quadrant dédié à ce marché en témoigne. La majorité des « leaders » (5 sur 9) ont droit à une remarque à ce sujet :

Autre sujet largement partagé parmi les « leaders » : la gestion des coûts.

Elle est difficile chez AWS faute de tarification unifiée entre services.

Elle l’est aussi pour beaucoup de clients de Databricks, malgré des avancées sur l’outillage FinOps.

Chez Google, elle a tendance à se complexifier avec l’intégration de nouvelles fonctionnalités.

Concernant Oracle, la clientèle se plaint toujours des prix et de la difficulté de contractualisation, même si la tendance s’atténue avec le passage au cloud et son modèle de facturation à l’usage.

Concernant Snowflake, Gartner a un jugement plus spécifique : le côté « user-friendly » est susceptible de favoriser le développement d’un état d’esprit « black box », et par là même de limiter la capacité à optimiser les workloads.

Plusieurs de ces fournisseurs avaient déjà été épinglés à ce sujet il y a un an, dans l’édition précédente de ce Magic Quadrant.

Databricks, à cause de la difficulté à prédire les coûts avec le modèle fondé sur des unités de consommation.

Google, parce que le suivi des dépenses pouvait se révéler délicat, a fortiori lorsqu’on interfaçait aux bases de données des services fondés sur des unités de consommation.

Oracle, perçu, de par son historique, comme un fournisseur aux offres onéreuses.

Alibaba, chez qui la variété des modèles de pricing, combinée à une facturation découplée pour certaines ressources au nom de la flexibilité, pouvait s’avérer difficile à maîtriser.

D’une année à l’autre, les critères à respecter ont peu évolué. Il fallait toujours, entre autres, gérer au moins un cas d’usage parmi :

Une fois encore, Gartner n’a évalué que les offres managées, fournies en cloud public ou privé. Il n’a pas pris en compte les bases de données hébergées sur du IaaS.

Les 20 fournisseurs classés sont les mêmes que l’an dernier. Et les 9 « leaders » d’alors le sont restés. Dans l’ordre alphabétique : Alibaba Cloud, AWS, Databricks, Google, IBM, Microsoft, MongoDB, Oracle et Snowflake.

Sur l’axe « exécution », reflétant la capacité à répondre à la demande, la situation est la suivante :

| Rang | Fournisseur | Évolution annuelle |

| 1 | AWS | = |

| 2 | = | |

| 3 | Microsoft | + 1 |

| 4 | Oracle | – 1 |

| 5 | Databricks | = |

| 6 | Snowflake | + 1 |

| 7 | MongoDB | – 1 |

| 8 | IBM | + 2 |

| 9 | Alibaba Cloud | – 1 |

| 10 | InterSystems | – 1 |

| 11 | Huawei Cloud | = |

| 12 | SAP | = |

| 13 | Teradata | = |

| 14 | Cloudera | = |

| 15 | Couchbase | + 3 |

| 16 | SingleStore | + 1 |

| 17 | EDB | + 3 |

| 18 | Redis | – 3 |

| 19 | Neo4j | – 3 |

| 20 | Cockroach Labs | – 1 |

Sur l’axe « vision », reflétant les stratégies :

| Rang | Fournisseur | Évolution annuelle |

| 1 | = | |

| 2 | Databricks | + 3 |

| 3 | Microsoft | – 1 |

| 4 | Oracle | – 1 |

| 5 | AWS | – 1 |

| 6 | Snowflake | + 2 |

| 7 | Alibaba Cloud | + 3 |

| 8 | IBM | – 1 |

| 9 | SAP | – 3 |

| 10 | Teradata | – 1 |

| 11 | MongoDB | = |

| 12 | Cloudera | = |

| 13 | InterSystems | + 2 |

| 14 | Neo4j | = |

| 15 | Huawei Cloud | + 1 |

| 16 | EDB | + 4 |

| 17 | Couchbase | = |

| 18 | SingleStore | = |

| 19 | Redis | – 6 |

| 20 | Cockroach Labs | – 1 |

Les principales offres d’Alibaba Cloud sur ce marché sont PolarDB et ApsaraDB (transactionnel), AnalyticDB et MaxCompute (analytique), Tair et Lindorm (clé-valeur).

L’a dernier, le groupe chinois avait été salué pour sa présence sectorielle importante et différenciée, le développement de son écosystème de partenaires et le poids de sa communauté open source.

Cette année, Gartner apprécie la tarification, jugée attractive. Ainsi que la fiabilité de l’architecture serverless. Désormais étendue à tous les SGBD, elle se distingue par son architecture découplant calcul, mémoire et stockage en environnement hybride. Bon point également pour l’approche « data + IA » qui permet de développer et de déployer des applications en n’utilisant que des technologies d’Alibaba Cloud.

L’an dernier, Gartner avait pointé, au-delà de la gestion des coûts, le risque géopolitique associé à Alibaba Cloud. Ainsi que la disponibilité encore limitée de ses servies hors de l’Asie (moins de régions et de zones de disponibilité que la concurrence).

Cette année encore, la faible présence hors Asie est signalée. Elle peut se traduire par un moins grand nombre d’intégrations d’outils tiers et de ressources en anglais (documentation, formation, support). Attention aussi à la configuration de PolarDB, jugée complexe par les nouveaux utilisateurs, notamment sur l’équilibre coût/performance et la gestion du stockage multicouche. Il faut y ajouter les chevauchements de produits sus-évoqués.

Aurora, Redshift, DynamoDB et SageMaker font partie des principaux produits d’AWS sur ce marché.

L’an dernier, Gartner avait salué la couverture fonctionnelle d’AWS et sa capacité à créer du liant entre ses solutions. Il avait aussi noté l’exhaustivité des partenariats et de la présence géographique.

Ce dernier point vaut toujours et s’assortit d’un bon historique de disponibilité de l’infrastructure ainsi que d’une approche « proactive » de dialogue avec le client pour l’optimisation des coûts. AWS a, plus globalement, un catalogue d’une ampleur sans égale sur ce marché, avec SageMaker comme point central de gouvernance data/IA.

L’intégration entre les services d’AWS peut être complexe, avait souligné Gartner l’an dernier. Le cabinet américain avait aussi constaté que la prise en charge des déploiements hybrides/multicloud était limitée malgré la disponibilité de connecteurs natifs et le support de moteurs comme Spark (les clients tendent à utiliser des orchestrateurs tiers, avait-il expliqué).

Ce dernier constat est toujours d’actualité : beaucoup de clients dépendent de solutions tierces pour l’orchestration hybride/multicloud. S’y ajoutent les deux éléments sus-évoqués : gestion des coûts difficile et chevauchements entre produits.

Outre Data Intelligence Platform (qui inclut Unity Catalog), Databricks propose du data warehouse avec Databricks SQL, du transactionnel avec Lakebase, ainsi que de l’intégration et de l’engineering avec Lakeflow.

L’an dernier, Gartner avait salué les investissements dans la GenAI (dont l’acquisition de MosaicML), traduits par le développement de ses propres LLM. Il avait aussi donne un bon point au catalogue Unity (qui venait d’être basculé en open source) et au format Delta Lake (concurrent d’Iceberg).

Cette année, Databricks est salué pour sa « vision lakehouse », bien qu’il ne soit plus seul sur ce marché. Il l’est aussi pour sa cadence d’innovation, entre la composante Agent Bricks (qui a reçu des fonctionnalités importantes presque tous les mois), l’acquisition de Tabular (qui a accompagné la prise en charge d’Iceberg sur tout le portefeuile) et l’introduction de capacités low code dans Lakeflow. Bon point également pour l’engagement sur des standards ouverts (Delta Lake, Iceberg, Spark, Postgre…) qui favorisent la portabilité.

L’an dernier, Gartner avait pointé le manque d’intuitivité de l’UI, qui changeait fréquemment tout en manquant de documentation et de capacités low code. Il y avait ajouté l’aspect FinOps, sus-évoqué.

Cette année, le cabinet américain met un bémol à la logique d’ouverture : certains clients s’inquiètent d’un éventuel verrouillage au niveau de l’orchestration et de Delta Live Tables (devenu Lakeflow Spark Declarative Pipelines). Il souligne par ailleurs la tendance des clients à juger que l’usage de la solution exige un haut niveau de compétence technique. En parallèle, le sujet FinOps reste valable (voir ci-dessus).

Entre autres produits positionnés sur ce marché, Google a Spanner, BigQuery, AlloyDB, Cloud SQL, Firestore, Memorystore et Bigtable.

L’an dernier, Gartner avait salué les contributions open source (à PostgreSQL en particulier). Il avait fait de même pour les avancées dans la GenAI (intégration de Gemini + support transversal de la recherche vectorielle via LangChain) et pour la fondation data/IA unifiée avec Dataplex pour la gouvernance.

Cette fondation data/IA a à nouveau droit à un bon point ; dans les grandes lignes, pour les mêmes motifs. Gartner note plus globalement la capacité de l’offre SGBD de Google à couvrir les cas d’usage dans l’IA agentique. Et apprécie en particulier l’exhaustivité des modèles de données pris en charge par Spanner (relationnel, clé-valeur, graphe, vectoriel).

Le réseau de partenaires doit encore se développer, avait estimé Gartner l’an dernier. Il avait aussi pointé l’aspect FinOps et souligné que Google proposait moins d’options que la concurrence pour l’intégration native d’applicaitons et le master data management.

Cette année, outre la gestion des coûts et les chevauchements sus-évoqués, un point de vigilance va à la marketplace de données et aux capacités de partage. Elle se révèlent moins avancées que chez certains concurrents, malgré des améliorations sur les clean rooms et l’interopérabilité entre clouds.

Les principaux SGBD cloud d’IBM sont Db2 (transactionnel + analytique) et watsonx.data (lakehouse).

L’an dernier, Big Blue s’était distingué sur sa stratégie sectorielle (solutions spécifiques adaptées sur la gouvernance, la sécurité et la conformité). Ainsi que sur sa capacité à combiner les expertises en open source et en data management au service des déploiements hybrides. Son offre est bien adaptée aux applications critiques, avait ajouté Gartner.

Cette année encore, la stratégie sectorielle est saluée. L’extension de la présence cloud l’est aussi (mise à disposition de Db2 chez les hyperscalers et acquisition de DataStax, qui a une forte présence multicloud). Bon point également pour l’approche « bien définie » d’IBM concernant l’intégration des SGBD dans les frameworks de data management.

IBM a du mal à se différencier dans la communication, par ailleurs pas uniforme entre équipes commerciales, avait expliqué Gartner l’a dernier. Il avait aussi rappelé que le déploiement géographique de l’offre n’atteignait pas encore celui des autres hyperscalers.

Les difficultés de communication restent d’actualité, occasionnant un certain manque de notoriété sur le segment. En parallèle, IBM demeure perçu comme un vendeur « legacy », ce qui est susceptible de détourner certains acheteurs. Gartner y ajoute, comme sus-évoqué, les chevauchements entre certains produits.

Entre autres produits, Microsoft évolue sur ce marché avec Azure SQL Database, Azure Database pour PostgreSQL et MySQL, ainsi qu’Azure Cosmos DB.

L’an dernier, Gartner avait salué l’exhaustivité de l’offre et le niveau d’intégration avec les autres services Microsoft. Il avait aussi apprécié les possibilités d’usage de l’IA pour le data management. Et les avancées sur la gestion du multicloud, exemplifiées par l’interconnexion Azure-Oracle comme par les « raccourcis » dans OneLake pour les analyses fédérées.

Bon point cette année encore pour l’exhaustivité de l’offre, qui « gère presque tous les modèles de données et cas d’usage sectoriels ». L’engagement de Microsoft sur PostgreSQL est également salué. Comme les innovations sur la partie IA (embeddings in-database, indexation de vecteurs, jonctions entre Copilot et Fabric…).

Le chevauchement de certaines offres avait déjà été signalé l’an dernier, en sus de craintes des clients sur la pérennité d’Azure Synapse Analytics et d’Azure Database face à Microsoft Fabric. Ce dernier manquait encore de maturité, avait expliqué Gartner : les capacités d’intégration, de gouvernance et de gestion des métadonnées étaient moins « robustes » que chez d’autres « leaders ». Le déploiement pouvait par ailleurs se révéler complexe, en particulier pour le DR, la sécurité et la gestion des coûts.

Outre le chevauchement de certains produits, Gartner pointe à nouveau le manque de maturité de Microsot Fabric. Les inquiétudes des clients touchent autant aux fonctions data warehouse que gouvernance, entre souveraineté, dimensionnement des ressources, prix, gestion des métadonnées et data quality. Attention aussi aux investissements consentis pour intégrer le transactionnel dans Fabric : sur le court terme, ils peuvent engendrer des enjeux de performance.

Outre son édition communautaire et son produit sur site (Enterprise Advanced), MongoDB propose son SGBD Atlas chez AWS, Google et Microsoft.

L’an dernier, Gartner avait salué une offre « bien considérée » pour ses capacités de traitement à haut volume, son élasticité et la flexibilité du schéma. Il avait aussi souligné la souplesse et la rapidité d’implémentation, contribuant à la popularité auprès des développeurs.

Ce dernier élément vaut toujours et engendre un vivier de compétences d’autant plus grand. S’y ajoute la richesse des options de déploiement, accentuée par un programme de partenariats jugé « robuste ». MongoDB est plus globalement parvenu à établir une forme de standard pour qui souhaite un modèle orienté document.

Si MongoDB associe transactionnel et analytique, son offre se limite à du non relationnel, avait signalé Gartner l’an dernier. La concurrence s’accentue de la part de fournisseurs de SGBD qui incluent l’approche document en plus d’autres modèles, avait-il souligné ; sans compter ceux qui proposent une compatibilité MongoDB.

Cette remaruqe sur la concurrence accrue reste valable. Le cabinet américain y ajoute la courbe d’apprentissage nécessaire pour prendre en main le modèle MongoDB. Et le manque d’un storytelling complet l’intégration du transactionnel et de l’analytique.

Autonomous AI Lakehouse, Autonomous JSON Database et Exadata Database Service font partie des SGBD cloud au catalogue d’Oracle.

L’an dernier, Gartner avait salué l’exhaustivité de l’offre (fonctionnalités + support de modèles modèles de données et de l’architecture lakehouse). Ainsi que le niveau de gestion du multicloud (offres Database@ + interconnexion avec les principaux hyperscalers) et la capacité à diffuser rapidement des nouveautés (GenAI, low code, consensus RAFT).

Cette année encore, la richesse fonctionnelle est saluée (bases de données distribuées, recherche vectorielle, framework agentique…). La diversité des options de déploiement l’est aussi. Comme l’adéquation de l’offre d’oracle aux applications critiques.

Oracl reste perçu comme onéreux et a du travail pour « cloudifier » sa base client, avait noté Gartner l’an dernier. Il avait aussi appelé les acheteurs à s’assurer de bien interpréter l’approche « une base de données pour tout » et ce qu’elle impliquait en matière de livraison de fonctionnalités.

Cette dernière remarque est reconduite : vigilance sur cette approche, qui s’oppose aux architecture combinant les SGBD et les systèmes de data management. La question du prix – sus-évoquée – reste sensible et les clients continuent à prioriser des produits concurrents pour les déploiements lakehouse.

L’an dernier, Snowflake s’était distingué par son UI adaptée à divers profils d’utilisateurs, sa prise en charge de multiples formats sur la couche de stockage et l’extension de l’architecture lakehouse avec Iceberg et Polaris.

Cette année encore, Gartner donne un bon à l’UI. Il relève aussi l’extension fonctionnelle de l’offre (data engineering avancé via Openflow, ML/IA avec Snowpark et Cortex AI, support de Postgre apporté par l’acquisition de Crunchy Data). Et l’amélioration de la scalabilité avec les entrepôts de génération 2 (meilleur rapport qualité-prix que la gen 1 pour les workloads complexes).

L’an dernier, Gartner avait pointé une prise en charge limitée des scénarios hybrides. Il y avait ajouté la complexité dans le partage des données entre organisations utilisatrices de Snowflake et les défis d’usabilité que posait l’intégration avec le stockage sur site via les tables externes.

Ces deux derniers aspect demeurent. D’une part, la performance n’est pas la même avec les tables externes qu’avec le stockage natif ou les tables Iceberg. De l’autre, sur le partage, il est nécessaire de bien planifier des éléments tels que les permissions, le repartage et les restrictions régionales. Gartner y ajoute l’aspect FinOps (voir ci-dessus). Et le fait que l’architecture est focalisée sur le batch et l’analytique plutôt que sur le transactionnel ou le temps réel (même s’il existe les tables hybrides et une intégration avancée de PostgreSQL).

Illustration générée par IA

The post Bases de données cloud : l’abondance de l’offre devient un défi appeared first on Silicon.fr.

Dans un e-mail envoyé aux utilisateurs, Google annonce que son outil de rapport sur le dark web va fermer ses portes au début de 2026. Celui-ci permettait de savoir si vos informations personnelles (nom, prénom, adresse, etc) avaient fuité le de le dark web à cause d’un piratage. …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Google arrête son service indiquant si vos données ont fuité sur le dark web est apparu en premier sur KultureGeek.

Vous vous souvenez des cassettes audio ? Mais siiii, ces trucs de nous les vieux quand on était jeune (spoiler : je suis toujours jeune !). Il fallait même rembobiner avec un crayon quand le lecteur bouffait la bande !!

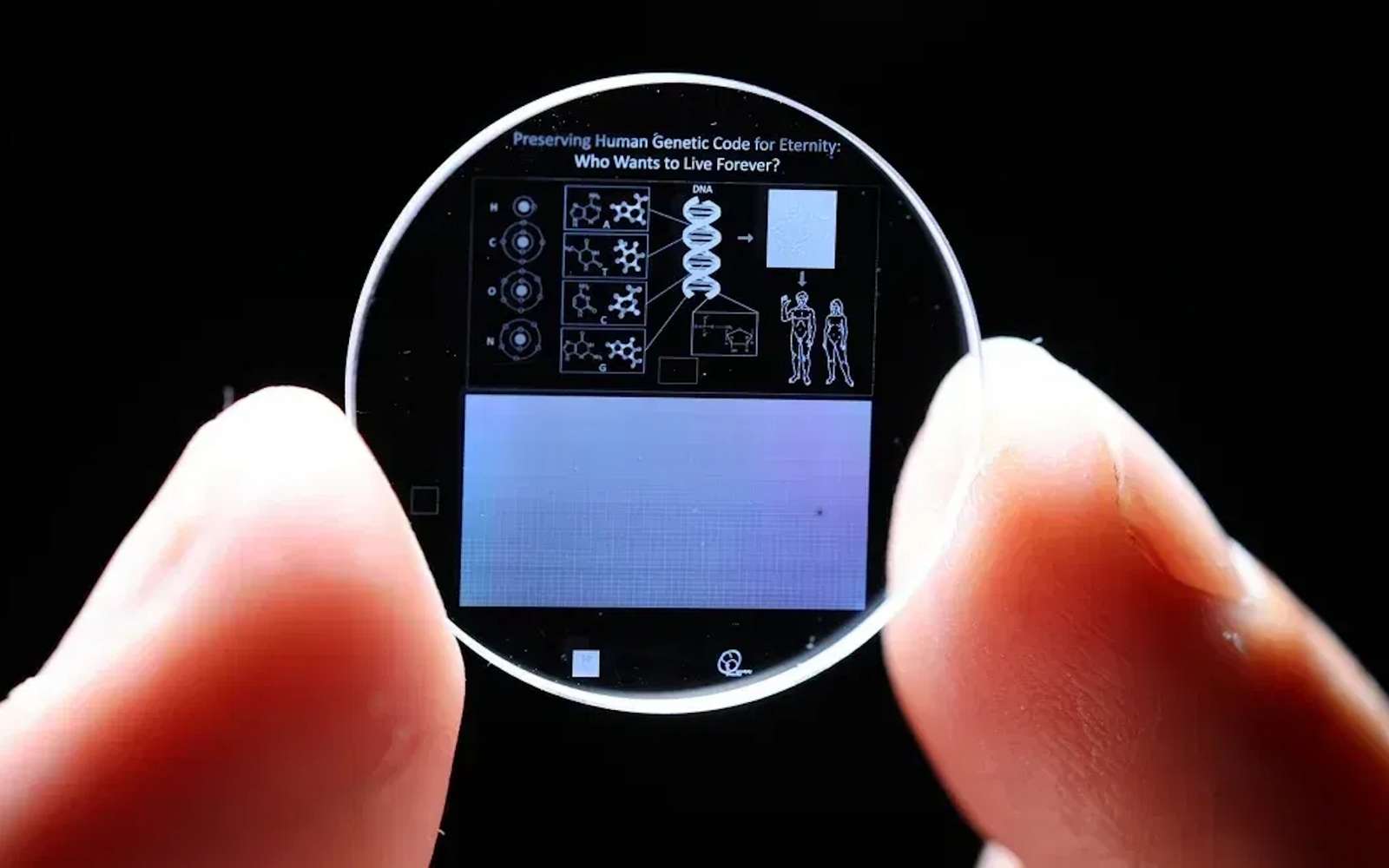

Hé bien des chercheurs chinois viennent de ressusciter ce format… mais version ADN. Et au lieu de stocker 90 minutes de musique, leur cassette peut théoriquement embarquer des quantités astronomiques de données.

L’équipe de Xingyu Jiang, ingénieur biomédical à la Southern University of Science and Technology de Shenzhen, a développé une bande pas comme les autres. Au lieu de la traditionnelle couche d’oxyde de fer, c’est de l’ADN synthétique qui est déposé sous forme de petits points microscopiques sur un film plastique flexible. Son prototype fait environ 5 mm de large sur 15 mètres de long et offre 545 400 emplacements adressables par kilomètre de bande. Côté capacité, on parle donc de 362 pétaoctets théoriques par kilomètre , mais en conditions réelles, l’équipe a stocké 74,7 Go par kilomètre pour le moment.

Bon, comment ça marche ce bazar ? Les données numériques sont converties en séquences ADN en utilisant les 4 bases nucléotidiques (A, T, C, G) à la place des 0 et des 1 habituels. La bande contient ces centaines de milliers d’emplacements adressables, et un système de lecture optique basé sur des codes-barres peut scanner jusqu’à 1570 partitions par seconde. C’est pas mal pour un truc basé sur des molécules biologiques.

Le vrai avantage de l’ADN comme support de stockage, c’est sa densité de ouf. Selon les chercheurs, l’ADN offre une densité théorique d’environ 455 exaoctets par gramme. Toutes les informations numériques mondiales pourraient tenir dans un volume ridiculement petit.

Et côté durabilité, c’est encore plus dingue, car là où vos disques durs claquent au bout de 1 à 10 ans et où les bandes magnétiques doivent être remplacées tous les 7 à 10 ans, l’ADN protégé par un revêtement métallo-organique (appelé ZIF) peut conserver les données pendant plus de 345 ans à température ambiante (c’est 20°C).

Et si vous le stockez dans un environnement froid comme les montagnes de Changbai en Chine, c’est parti pour 20 000 ans de stockage OKLM. Vos arrière-arrière-arrière-petits-enfants pourront encore récupérer vos TikTok de vacances et autres backups de dickpics.

Le système permet aussi de récupérer des fichiers sans détruire les données sources. Les chercheurs ont testé 10 cycles de récupération sur une même partition et les données restent intègres. Mieux encore, on peut supprimer et redéposer de nouveaux fichiers sur les mêmes emplacements, tout cela grâce à un algorithme de correction d’erreurs (Reed-Solomon) qui permet de conserver une bonne fiabilité des données malgré les manipulations.

Pour l’instant, la technologie reste quand même hyper leeeeeeente. En mode continu, les chercheurs atteignent un débit théorique de 2,3 fichiers par seconde, mais ça reste très loin des performances des bandes LTO actuelles, et au niveau coût, c’est pas jojo non plus, car la synthèse d’ADN reste très coûteuse, même si les prix baissent. Bref, y’a encore du boulot.

L’objectif des chercheurs est donc très clair. Il s’agit de créer un support de stockage durable pendant des siècles et indépendant de l’obsolescence des technologies actuelles. Car ouais, en 2025 retrouver un fichier sur une disquette, c’est quasi mission impossible alors qu’avec l’ADN, le format de lecture (le séquençage) continuera d’exister tant que la biologie moléculaire existera.

Tout ça pour dire que même si on n’est pas près de stocker nos bibliothèques Steam sur une cassette ADN, pour tout ce qui est archivage à très long terme de données “froides”, ça a énormément de potentiel.

Source : Science Advances