Vue lecture

La Centrale veut transformer radicalement le business model du marché VO entre professionnels

L'IA est un risque existentiel: l’alerte de Dario Amodei

> Celui qui l’affirme est à l’origine de Claude, l’une des IA les plus utilisées aujourd’hui.

> Le patron d’Anthropic en est convaincu : sans un sursaut, l’humanité peut s’effondrer.

C'est (très) long, je suis en train de l'imprimer pour le lire au calme.

Juste une citation piochée au hasard, dans les dernières pages :

> C’est là le piège : l’IA est si puissante et si lucrative qu’il est très difficile pour la civilisation humaine de lui imposer la moindre restriction.

(Permalink)

L'IA est un risque existentiel: l’alerte de Dario Amodei

> Celui qui l’affirme est à l’origine de Claude, l’une des IA les plus utilisées aujourd’hui.

> Le patron d’Anthropic en est convaincu : sans un sursaut, l’humanité peut s’effondrer.

C'est (très) long, je suis en train de l'imprimer pour le lire au calme.

Juste une citation piochée au hasard, dans les dernières pages :

> C’est là le piège : l’IA est si puissante et si lucrative qu’il est très difficile pour la civilisation humaine de lui imposer la moindre restriction.

(Permalink)

La hausse des prix des GeForce RTX de NVIDIA serait lié à un programme interne

La hausse des prix des GPUs NVIDIA ne serait pas uniquement liée au coût de la mémoire. La fin d’un mystérieux programme fait parler de lui

La hausse des prix des GPUs NVIDIA ne serait pas uniquement liée au coût de la mémoire. La fin d’un mystérieux programme fait parler de lui

Cet article La hausse des prix des GeForce RTX de NVIDIA serait lié à un programme interne a été publié en premier par GinjFo.

C’est prouvé, l’IA copie des œuvres protégées

On n'avait que très peu de doute sur la question, mais cette étude vient confirmer les soupçons.

NVIDIA négociait avec Anna's Archive pour entraîner ses IA... et les emails ont fuité

Bon, celle-là elle est gratinée. NVIDIA, le géant des GPU, a directement contacté Anna's Archive pour accéder à environ 500 To de livres piratés. Contacté, négocié, payé. Comme ça, tranquillou.

C'est une class action (dossier n°1:26-cv-00002 au tribunal fédéral de New York, pour ceux qui veulent aller checker) qui a fait fuiter ces fameux emails internes. En gros, un membre de l'équipe "data strategy" de NVIDIA a négocié un accès haute vitesse aux collections piratées de la bibliothèque. Et le plus beau dans l'histoire c'est qu'Anna's Archive les a PRÉVENUS que les données étaient illégales. Genre, texto : "Vous avez une autorisation interne pour ça ?"

La réponse est arrivée en moins d'une semaine. Feu vert. Sauf que bon, quand on lit ça avec du recul, c'est quand même sacrément culotté.

Le contexte, c'était surtout la pression de livrer pour la GTC 2023 (la Developer Conference de NVIDIA). Fallait nourrir les modèles d'IA coûte que coûte, et le dataset Books3 (196 000 bouquins issus de Bibliotik), plus LibGen, Sci-Hub, Z-Library... ça faisait un buffet de 500 To et de leur côté Anna's Archive facturait des dizaines de milliers de dollars pour l'accès rapide.

Sérieux, j'aurais aimé voir la tête du service juridique de NVIDIA en lisant cet email...

En parallèle, Anna's Archive se prend un procès complètement délirant puisque Spotify, Universal Music, Warner et Sony réclament 13 000 milliards de dollars (13 TRILLIONS, soit à peu près le PIB de la Chine). C'est en lien avec leur backup de 300 To de Spotify dont je vous avais parlé ici. Le juge Rakoff a émis une injonction mondiale le 20 janvier, ce qui a fait tomber plusieurs domaines du site .

NVIDIA plaide le "fair use" évidemment. Mouais. On verra bien ce qu'en pensera le juge, mais quand les emails prouvent qu'on t'a prévenu que c'était illégal et que t'as quand même dit "go"... c'est pas ouf comme défense.

En attendant, entre le procès Spotify et ces emails, Anna's Archive est devenue l'ennemi public numéro un de toute l'industrie du contenu sur le web.

Affaire à suivre !

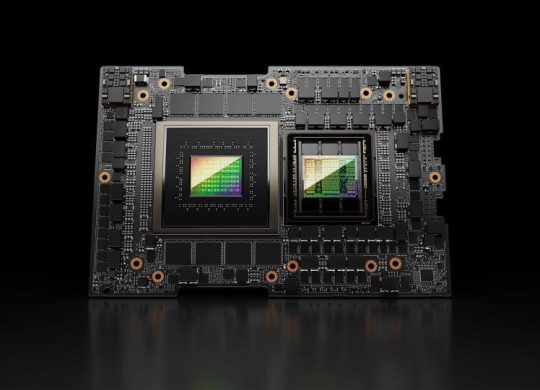

La Chine autorise l’importation des GPU NVIDIA H200 pour accélérer ses ambitions en IA

Après plusieurs mois d’incertitude, la Chine vient d’approuver une première vague d’importations des puces graphiques NVIDIA H200, destinées aux applications avancées en intelligence artificielle. Cette décision marque un tournant stratégique pour l’écosystème technologique chinois, en quête de performances accrues pour ses infrastructures de calcul, et ce malgré un …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article La Chine autorise l’importation des GPU NVIDIA H200 pour accélérer ses ambitions en IA est apparu en premier sur KultureGeek.

Les bolides les plus fous de l’histoire du rallye s’exposent au salon Rétromobile 2026

Les premières applications MCP « interactives » arrivent

Une dizaine d’applications connectées à Claude sont désormais « interactives ».

En toile de fond, la stabilisation de la spécification MCP Apps. Elle avait pris forme il y a quelques semaines, à la croisée du projet MCP-UI et de l’Apps SDK d’OpenAI, avec Anthropic dans la boucle. La promesse : standardiser la déclaration de ressources UI par les serveurs MCP.

La spec initiale se concentre sur le contenu text/html. Elle sépare les données des templates pour permettre aux applications hôtes de contrôler ces derniers avant exécution. Le rendu passe par un iframe. Les communications se font sur JSON-RPC et sont donc auditables.

Lors de la connexion à un serveur MCP, l’hôte signale s’il gère ou non ces composants UI. Dans la négative, les outils associés ne délivrent que du texte. Il communique aussi diverses préférences : locale et timezone, thème (clair ou sombre), mode d’affichage (inline, plein écran ou incrustation), plate-forme (mobile, web ou desktop)…

9 applications interactives pour commencer

Microsoft a intégré MCP Apps dans Visual Studio Code pour les bêtatesteurs. L’agent de codage Goose a aussi franchi le pas. Comme OpenAI, censé officialiser dans la semaine ses premières « applications interactives » fondées sur cette spécification.

En attendant, on peut en expérimenter une dizaine sur les versions payantes de Claude (Pro, Max, Team, Enterprise).

Amplitude

Mis à jour avec le support de MCP Apps, le connecteur pour Amplitude permet de créer des graphes et de les explorer (modification du format, affichage d’informations au survol, lien pour les ouvrir dans le navigateur).

Asana

Avec MCP Apps, le connecteur Asana peut créer des projets à partir de prompts et/ou de documents. Pour chaque tâche, les assignations et les dates d’échéance sont modifiables sur l’interface, où on peut aussi afficher une vue calendrier.

Box

MCP Apps permet au connecteur Box d’avoir un aperçu d’un fichiers et de poser des questions à son sujet. L’IA de Box peut prendre le relais de Claude pour résumer des documents et en extraire des actions ou des données structurées.

Canva

MCP Apps pour le connecteur Canva donne la possibilité de créer divers types de contenus (diagrammes, présentations, templates…), de les éditer, d’y faire des recherches et des les redimensionner/exporter.

Clay

En plus des visualisations interactives, MCP Apps apporte, entre autres possibilités, la génération et l’édition de texte, ainsi que la consultation de cartes de profils avec possibilité d’envoyer un message.

Figma

La création de diagrammes – y compris à partir de documents – arrive aussi dans l’application Figma. L’interface permet également d’implémenter un design en HTML/CSS et d’implémenter des composants en s’appuyant sur les standards d’une codebase.

Hex

MCP apporte diverses visualisations interactives (diagrammes, tables, étapes de raisonnement). Les réponses héritent du contexte et des contrôles d’accès de l’espace de travail Hex, nous précise-t-on.

Monday.com

Les visualisations apportées par MCP Apps permettent de créer des tableaux (boards), de mettre à jour le statut de certains éléments et d’obtenir des suggestions pour l’attribution de tâches.

Slack

Telle que présentée, l’intégration Claude-Slack à la mode MCP Apps permet de composer/éditer des messages et de les envoyer dans des canaux ou à des membres d’équipe.

Toutes ces fonctionnalités sont accessibles sur le web et la version de bureau. Pas sur l’app mobile Claude. Anthropic affirme qu’il les étendra « bientôt » à son produit Cowork.

Illustration principale générée par IA

The post Les premières applications MCP « interactives » arrivent appeared first on Silicon.fr.

LLM Visualization

Très impressionnant : une représentation visuelle et animée d'un LLM (simplifié, 85k paramètres), avec toutes les étapes et les explications. Il faut appuyer sur espace pour passer d'une étape à l'autre.

— Permalink

Les drivers GeForce 591.86 WHQL sont disponibles

Le fabricant NVIDIA vient de publier aujourd'hui la version 591.86 WHQL des pilotes GeForce. Les drivers supportent à présent les jeux Arc Raiders: Headwind et Arknights: Endfield.

The post Les drivers GeForce 591.86 WHQL sont disponibles first appeared on Bhmag.10 chiffres sur le déploiement de l’IA chez France Travail

Dix ans déjà que « La bonne alternance » a émergé chez France Travail, dans la lignée de « La bonne boîte ».

Ces services font chacun intervenir un algorithme qui analyse les recrutements passés pour prédire ceux à venir. Ils ont fait partie des premiers cas d’usage de l’IA au sein de l’établissement public.

Depuis, deux programmes se sont organisés. D’abord, « Intelligence emploi », mis en œuvre en 2019 et 2022. Il a permis la constitution d’une plate-forme technologique sur base open source et d’une équipe au sein de la DSI. Ensuite, « Data IA », engagé depuis 2024. Il est motivé par l’IA générative, le renforcement du pilotage de la donnée et l’élargissement des missions de France Travail avec la loi plein emploi.

La Cour des comptes s’est intéressée au déploiement de l’IA par l’agence d’emploi publique sur la période 2017-2025. Voici quelques éléments tirés de son rapport.

87 cas d’usage

La Cour des comptes a relevé 87 cas d’usage déployés ou testés sur la période en question.

Parmi eux, 27 sont utilisés à grande échelle. 16 sont en test. 25 sont en cours de conception. 17 ont été abandonnés au stade du test ou après déploiement. Plusieurs sont les variantes d’un même outil. Notamment de ChatFT (chatbot généraliste).

L’essentiel de ces 87 cas d’usage – 61, dont 26 déployés – ont pour seuls bénéficiaires directs les agents de France Travail. L’illustration, selon la Cour des comptes, d’une volonté de développer d’abord une culture de l’IA en interne.

Les principaux cas d’usage dont les demandeurs d’emploi sont bénéficiaires directs visent à :

- Faciliter le remplissage du profil dans l’espace personnel

- Suggérer des métiers en fonction des compétences

- Lire automatiquement les documents téléchargés et extraire des informations

Ces cas d’usage présentent des résultats plutôt positifs. Parmi eux, l’analyse automatique des CV, qu’utilisent 75 % des demandeurs d’emploi.

Des 6 cas d’usage bénéficiant directement aux entreprises, 3 ont été abandonnés en 2017. L’un touchait à l’analyse prédictive de l’attractivité des offres d’emploi.

Les deux seuls actuellement déployés consistent à :

- Prévoir le délai de pourvoi d’une offre à 30 jours (peu utilisé)

- Présenter, sur un site public, des données générales sur l’emploi à l’échelon territorial (peu de valeur ajoutée dans les projets de recrutement)

9 % d’utilisateurs quotidiens de l’IA

L’effectif de France Travail avoisine 54 000 agents.

Sur 34 945 ayant répondu à une enquête interne menée en mars 2025, 9 % ont déclaré utiliser chaque jour l’IA mise à leur disposition. 18 % ont affirmé s’en servir plusieurs fois par semaine. 39 % ont dit ne pas y recourir.

ChatFT est accessible à tout le personnel depuis novembre 2024. À fin juin 2025, 37 600 agents l’avaient utilisé au moins une fois. Ce mois-là, 17 400 s’en étaient servis au moins trois journées distinctes.

Sur la fin de la phase de test, une étude interne sur environ 700 conversations avait révélé que l’usage principal consistait à formuler des réponses à des e-mails (51 % des conversations), loin devant la recherche d’informations générales (10 %).

108 millions d’euros de coûts

En retenant une estimation basse des coûts de développement, France Travail a mobilisé 93 M€ pour l’IA entre 2017 et 2024.

| Période | Montant des dépenses |

| Avant 2018 | 3 M€ |

| Intelligence emploi 2018-2022 | 64 M€ |

| Data IA 2019-2022 | 9 M€ |

| Data IA 2023-2024 | 16 M€ |

| Autres dépenses non rattachées | 1 M€ |

Les « autres dépenses non rattachées » correspondent aux budgets pour une application « Reconnaissance des émotions ».

On en arrive aux 93 M€ sus évoqués. En y ajoutant le budget prévisionnel de 15 M€ pour 2025, le coût total du développement de l’IA sur la période considérée s’élève à 108 M€. La Cour des comptes compare ce montant aux 66 M€ que le ministère de l’Économie et des Finances a engagés sur 2015-2023 et explique la différence par un plus grand nombre de relations directes avec les usagers.

120 M€ de gains d’efficience

On atteint ce montant en retenant une estimation haute des gains réalisés depuis 2017. Cela inclut trois gains directs attendus :

- Cas d’usage du programme « Intelligence emploi » : 205 ETP par an à partir de 2023

- Service « Upload simplifié » (reconnaissance de documents) : 350 ETP/an à partir de 2024

- Service MatchFT (préqualification de profils par échange de SMS avec une IA) : 100 ETP en 2025

Soit, sur l’ensemble de la période étudiée, un total de 1415 ETP, que la Cour des comptes estime valorisables à 85 M€.

Les gains « indirects » liés à une charge de travail évitée par les conseillers seraient de 375 ETP. D’un côté, pour l’analyse automatique de CV, 27 ETP e 2023 et 48 par an à partir de 2024. De l’autre, 84 ETP par an à partir de 2023 pour le service « Lego », qui identifie les offres d’emploi illégales et empêche leur diffusion. L’ensemble serait valorisable à 23 M€.

Il faut y ajouter les coûts évités du fait du remplacement de logiciels par certains cas d’usage. En première ligne, la reconnaissance automatique de documents avec « Upload simplifié ».

14,4 M€ de dépassement pour « Intelligence emploi »

Le budget prévu pour ce programme était de 49,5 M€.

Le budget exécuté s’est élevé à 63,9 M€ (29 M€ de masse salariale, 33,9 M€ de dépenses de fonctionnement et 1 M€ de dépenses d’investissement).

France Travail justifie ce dépassement par l’allongement de 10 mois de la durée du projet, essentiellement en raison :

- De la crise Covid

- Du développement de cas d’usage initialement non prévus (Lego, analyse des CV, aide à la recherche d’info sur les sites de Pôle emploi…)

- De la comptabilisation de dépenses liées aux capacités techniques communes à d’autres développements de solutions d’IA non intégrées au programme

Dès janvier 2020, donc avant l’épisode Covid, la Dinum avait alerté quant au montant de dépenses de prestations intellectuelles envisagé (22,7 M€). Elle l’avait jugé « surdimensionné pour une démarche exploratoire dont le retour sur investissement n’est pas garanti ».

Les prestations extérieurs ont, en définitive, coûté 33,9 M€.

La Dinum avait aussi anticipé, à raison, le potentiel incertain d’appropriation, par les conseillers, du cas d’usage « Gestion automatisée des mails et assistant virtuel ». Pôle emploi avait refusé d’y mettre un terme, au motif que des gains d’efficience et de satisfaction pourraient être constatés à court terme.

205 ETP gagnés avec « Intelligence emploi »

En 2018, Pôle emploi prévoyait un gain annuel de 164 ETP à l’horizon 2022 (87 grâce à « Contact via mail » et 77 par l’utilisation d’un chatbot).

Le gain a finalement atteint 205 ETP (107 grâce à « Contact via mail », le reste via Lego). Objectif dépassé, donc ; mais qui, a posteriori, apparaît peu ambitieux. La Cour des comptes en veut pour preuve le ROI significativement plus faible que pour une sélection de projets IA du ministère de l’Économie et des Finances.

Ces gains ne se sont pas traduits par une réduction nette des effectifs, mais par des « redéploiements intra-postes ».

De 18 à 4 mois pour déployer un cas d’usage

Avant le premier programme, il fallait 18 mois pour déployer un cas d’usage. Il en faut maintenant 4. En parallèle, le recours à des intervenants extérieurs est passé de 60 % des prestations globales sur 2019-2020 à 40 % sur 2021-2022.

Des six cas d’usage principaux réalisés sur la durée du programme « Intelligence emploi », trois étaient consacrés essentiellement à faciliter le travail des conseillers. Un déséquilibre entre les publics ciblés qui allait s’accentuer avec le programme « Data IA ».

Avant le lancement du programme « Intelligence emploi », France Travail avait détecté plus de 80 cas d’usage potentiels. 90 % se sont révélés inadéquats. Essentiellement du fait de difficultés au niveau de la data ou de l’intégration au SI, ou à cause d’une surestimation de la valeur.

30 minutes de moins pour remplir un profil

Les cas d’usage mis en place lors du premier programme ont entraîné des gains d’efficience assez limités. Quelques minutes par jour pour la gestion des e-mails, par exemple.

La valeur ajoutée réside surtout dans le service rendu. L’analyse automatique du CV réduit ainsi de 45 à 15 minutes le temps nécessaire au demandeur d’emploi pour remplir son profil de compétences.

779 ETP à libérer sur 2025-2027

Le travail de transformation engagé pour répondre à l’élargissement des missions de France Travail est formalisé dans un programme, prolongé dans un plan d’efficience sur 3 ans (2025-2027).

Aux dernières nouvelles, ce plan vise à dégager un gain équivalant au minimum à 3192 ETP. L’IA doit y concourir à hauteur de 779 ETP.

En avril 2025, il était question de 822, dont 78 % provenant de trois cas d’usage :

- Aide rédactionnelle via ChatFT (226 ETP)

- Préparation d’entretiens via Néo, moteur de recherche d’infos dans les dossiers des demandeurs d’emploi (241 ETP)

- Alimentation plus facile de la GED via Panoptes (157 ETP), dont « Upload simplifié » est la déclinaison sur le site Internet de France Travail (en agence, cela s’appelle « Scanner », la version proposée aux services de l’État se nommant « Scanlab »)

Une analyse éthique pour 18 cas d’usage

Le respect des engagements pris dans la charte éthique publiée en avril 2022 n’est pas garanti, note la Cour des comptes. Seuls 18 cas d’usage ont fait l’objet d’un début d’analyse éthique formalisé.

Le recours à l’IA s’inscrit dans un contexte de numérisation de la relation avec France Travail. Entre 2017 et 2024, le nombre de visites annuelles en agence a chuté de 42 %. Tandis que le volume d’e-mails a augmenté de 72 %.

Illustration générée par IA

The post 10 chiffres sur le déploiement de l’IA chez France Travail appeared first on Silicon.fr.

Spirale Dynamique | « vous ne pourrez jamais convaincre un singe de vous donner une banane en lui promettant des bananes sans limites après sa mort au paradis des singe... | Facebook

5 janvier 2023:

« vous ne pourrez jamais convaincre un singe de vous donner une banane en lui promettant des bananes sans limites après sa mort au paradis des singes »

Ce qui signifie juste — en termes spiraux — que les singes n’ont pas atteint le niveau Bleu 💙🙃😉

Ce motif d’existence Bleu, qui dessine et se destine à servir tout dessein plus grand que soi et plus lointain que le contexte immédiat.

💙💙💙💙💙💙💙💙💙💙💙💙💙💙💙

Vu qu'on mentionne Harari.. J'ai lu son bouquin "Sapiens". J'y ai trouvé des infos intéressantes sur les temps anciens. Mais plus le livre avance plus j'ai un malaise dans ses explications.

C'est difficile pour moi d'identifier ce qui me rend mal à l'aise.

Une des pistes, est que son discours est un peu du même style que celui qu'on peut avoir quand on converse avec ChatGPT.... l'IA sait très bien imiter un discours plausible. Mais la réalité concrète physique ne tient pas la route. (on le voit très bien aussi avec les IA graphique comme midJourney... l'ambiance est bonne, mais si on regarde les détails c'est foireux... notamment les mains... souvent à 7 doigts..)

Par exemple sur le sujet de l'histoire de la monnaie et des systèmes économique dont je connais bien le sujet, j'ai vu chez Harari que son discours est faux !

Il cite Graeber et le fait que le troc n'a jamais fait système, mais il n'a pas l'air d'avoir intégré ceci dans la suite du discours. Donc ça sonne faux.. incohérent...

Du coup j'ai pas voulu continuer la lecture avec Homo Deus... j'en ai eu un bon résumé et ça a confirmé mon envie de ne pas le lire...

Alors je ne sais pas si d'autres parmi vous ont lu Harari ? Qu'est-ce que vous en pensez ?

Perso, la spirale dynamique reste encore et toujours le meilleur modèle d'explication de la vision du monde des humains que je connaisse.

Pour les singes, je pense qu'il y a de grande chance que ça puisse s'appliquer un bout... y'a des théorie génétique qui montrent qu'on est pas si loin...

JP:

Complément d’accord, « Sapiens » intéressant mais dissonant et orangeo centré selon moi. La relation humaine y est surinvestie mais creuse, comme avec du Vert projeté, d’où mon hypothèse lors de ma lecture d’une dynamique Orange/vert — ou dit aussi « orange sortant » — chez lui.

Il n’aurait pas accompli la stabilisation en Vert, selon mon hypothèse, du moins comme la cohérence paradigmatique de sa structure de motivation-conceptualisation dans ce livre-là.

Pas eu l’envie d’aller plus loin avec lui non plus 🙄😬

--

JK:

Ah, pour une fois je fais la même analyse sur Harari.

Quand j'ai appris en plus par la suite son implication dans les milieux type "forum de Davos" ça m'a encore plus confirmé dans cette analyse.

Pourtant paradoxalement son livre m'a beaucoup aidé à saisir certaines choses de vert.

— Permalien

Puces IA : face à Amazon et Google, Microsoft se replace

Microsoft, désormais au niveau de Google et d’Amazon sur les puces IA ?

La deuxième génération des accélérateurs Maia – tout juste annoncée – s’accompagne en tout cas d’un comparatif de performance. Cela n’avait pas été le cas pour la première, présentée fin 2023.

D’une génération à l’autre, on est passé de 5 à 3 nm, de la HBM2 à la HBM3… et d’une approche généraliste à un message centré sur l’inférence, avant tout à faible précision (4 et 8 bits).

Vu ce focus, on aurait pu penser que Microsoft ferait la comparaison avec les puces Inferentia2 d’Amazon. Mais celles-ci ont, il est vrai, un certain âge (introduites fin 2022). L’accélérateur Maia 200 est donc opposé aux Trainium3 (dévoilées en décembre 2025 ; dédiées à l’entraînement). Ainsi qu’à la dernière génération de TPU de Google (Ironwood, introduite en avril 2025).

| Maia 200 | Trainium3

(specs disponibles ici) |

TPUv7x

(specs disponibles ici) |

|

| Mémoire HBM | 216 Go | 144 Go | 192 Go |

| Bande passante HBM | 7 To/s | 4,9 To/s | 7,4 To/s |

| Bande passante scale-up | 2,8 To/s | 2,56 To/s | 1,2 To/s |

| BF16 | 1268 Tflops | 671 Tflops | 2307 Tflops |

| FP8 | 5072 Tops | 2517 Tops | 4614 Tops |

| FP4 | 10 145 Tops | 2517 Tops | n/a |

Microsoft annonce une enveloppe thermique de 750 W pour Maia 200, tandis que les puces d’Amazon et de Google fonctionnent à environ 1000 W. Au final, il prétend que son accélérateur est « 40 % moins cher que les autres »…![]()

Les puces Maia, pas exposées directement au client

Maia 100 n’est pas exposé directement aux clients finaux : il porte des services comme Copilot et Azure OpenAI, ainsi que des workloads HPC. La même stratégie se dessine avec les accélérateurs Maia 200. La division Microsoft Superintelligence en sera la première utilisatrice. On nous parle aussi d’une exploitation dans le cadre de Microsoft 365 et d’Azure AI Foundry. Mais pas d’une mise à disposition dans l’offre de compute.

Physiquement parlant, les premières puces seront localisées dans la région US Central (Iowa). La région US West 3 (Arizona) suivra. Elles sont déployables en configuration à refroidissement liquide ou à air.

De Maia 100 à Maia 200, on retrouve une couche réseau basée sur Ethernet, avec un protocole type RoCE. Une topologie intranœud est mise en place, connectant des groupes de 4 puces « en direct », sans switch. Un cluster peut accueillir au maximum 6144 puces.

La couche mémoire évolue, avec un partitionnement de la SRAM (272 Mo par puce) en deux niveaux logiques, chacun ayant son sous-système DMA. Le premier (TSRAM) alimente les tiles (plus petite unité autonome de calcul et de stockage local, embarquant moteurs matriciel et vectoriel) ; le deuxième (CSRAM), les clusters.

Cette approche favorise diverses stratégies de data management en fonction des noyaux. Les kernels d’attention, par exemple, peuvent épingler des tenseurs en TSRAM pour minimiser l’overhead. Tandis que les pipelines cross-kernel peuvent exploiter la CSRAM comme tampon pour le chaînage à haut débit.

Illustrations © Microsoft

The post Puces IA : face à Amazon et Google, Microsoft se replace appeared first on Silicon.fr.

Pourquoi Nvidia multiplie ses investissements en Europe dans l’IA

L’accélération est spectaculaire. Nvidia a intensifié ses investissements dans les jeunes pousses européennes de l’IA, participant à 14 tours de financement en 2025 ( sur un total de 86), selon la plateforme Dealroom. Un doublement par rapport aux sept opérations de 2024, et une progression fulgurante quand on sait que le fabricant de puces n’avait réalisé aucun investissement sur le continent en 2020 et 2021.

Cette offensive européenne de Jensen Huang s’inscrit dans une stratégie mondiale d’envergure. pour tisser des liens étroits avec les sociétés les plus prometteuses du secteur, en leur apportant non seulement des capitaux, mais aussi une expertise technique et un accès privilégié à sa chaîne d’approvisionnement.

Des montants records déployés

Parmi les opérations les plus marquantes figure le troisième investissement de Nvidia dans le français Mistral AI, qui a levé 1,7 milliard € en septembre 2025, atteignant une valorisation de 11,7 milliards €.

Autre investissement majeur, les 500 millions de livres sterling dans Nscale, annoncé en septembre par Jensen Huang lui-même. Cette startup britannique, qui développe des centres de données et fournit des services de cloud computing pour l’IA, a rapidement bouclé deux tours de financement successifs fin septembre et début octobre, avec Nvidia à chaque fois au capital.

Le géant américain a également soutenu le laboratoire allemand Black Forest Labs en décembre, participant à une levée de 300 millions $ qui a propulsé la valorisation de cette société spécialisée dans les modèles d’IA pour le contenu visuel à 3,25 milliards $. Nvidia était aussi de la partie lors de la levée de fonds de Lovable, une startup travaillant sur le « vibe coding », valorisée à 6,6 milliards $

Autre pari relevé : celui sur Quantinuum, une entreprise d’informatique quantique qui a levé des fonds en septembre avec le soutien de Nvidia, atteignant une valorisation de 10 milliards $. Ces capitaux doivent financer le développement du système quantique de nouvelle génération Helios.

L’Europe, terre d’opportunités pour l’IA physique

Cette tendance s’est poursuivie en 2026. La startup britannique Synthesia a ainsi annoncé la participation de Nvidia à son dernier tour de table.

Pour Jensen Huang, qui s’exprimait récemment au Forum économique mondial de Davos, l’Europe dispose d’atouts considérables dans la robotique et l’intelligence artificielle physique. L’Europe possède une base industrielle et manufacturière particulièrement solide, qu’elle peut désormais fusionner avec l’IA pour se positionner sur ce marché émergent. Cette combinaison permettrait même à l’Europe de rattraper son retard dans le domaine logiciel, dominé par les États-Unis.

Reste un défi majeur : l’énergie. Jensen Huang a martelé ce point à Davos : pour que l’écosystème de l’IA puisse se développer pleinement en Europe, le continent doit résoudre la question de son approvisionnement énergétique. Avec des coûts parmi les plus élevés au monde, l’Europe peine à attirer les investissements massifs nécessaires au déploiement des infrastructures d’IA. Un constat partagé par Satya Nadella, le patron de Microsoft, qui juge que les coûts énergétiques seront déterminants dans la course mondiale à l’IA.

Un écosystème en pleine ébullition

Au-delà de l’Europe, Nvidia s’impose comme le faiseur de rois de l’IA. Les hyperscalers se précipitent pour construire leurs capacités et le groupe dispose de liquidités considérables à déployer. Jensen Huang parle du démarrage du plus grand déploiement d’infrastructures de l’histoire de l’humanité.

Les chiffres parlent d’eux-mêmes. L’année 2025 a enregistré l’un des plus hauts niveaux d’investissement en capital-risque jamais atteints, avec plus de 100 milliards $ déployés dans le monde, essentiellement vers des startups natives de l’IA. Ces entreprises opèrent dans la santé, la robotique, l’industrie manufacturière et les services financiers, des secteurs où les modèles d’IA sont désormais suffisamment matures pour permettre le développement d’applications concrètes.

——

Les principaux investissements de Nvidia en Europe en 2025

| Startup | Pays | Secteur | Montant levé | Valorisation | Date |

|---|---|---|---|---|---|

| Mistral AI | France | Modèles de langage IA open source | 1,7 Md€ | 11,7 Md€ | Sept. 2025 |

| Nscale | Royaume-Uni | Centres de données / Cloud IA | 500 M£ | N.C. | Sept. 2025 |

| Black Forest Labs | Allemagne | Modèles IA pour contenu visuel | 300 M$ | 3,25 Md$ | Déc. 2025 |

| Lovable | N.C. | « Vibe coding » | N.C. | 6,6 Md$ | 2025 |

| Quantinuum | N.C. | Informatique quantique | N.C. | 10 Md$ | Sept. 2025 |

The post Pourquoi Nvidia multiplie ses investissements en Europe dans l’IA appeared first on Silicon.fr.

Gamers vs IA - Des jeux annulés sur de simples suppositions... mais lol

Alors ça, c'est une news qui m'énerve un peu ! Parce que oui, écouter sa communauté c'est bien, sauf que ça veut pas dire qu'elle a toujours raison.

En ce moment, y'a une vague de joueurs en colère qui forcent des studios de jeux vidéos à annuler des projets ou à prendre leurs distances avec tout ce qui touche de près ou de loin à l'IA générative. Et du coup, des jeux se font dézinguer avant même d'avoir prouvé quoi que ce soit.

Prenez Postal: Bullet Paradise. Le trailer sort, des joueurs crient à l'IA dans les graphismes, et hop, l'éditeur Running With Scissors annule tout . Le studio Goonswarm Games ferme boutique. Pouf, tout ça pour des soupçons ! Ils ont admis après coup que du matos promo contenait peut-être de l'IA, mais le jeu lui-même ? Nop, y'avait pas d'IA. C'est con hein ?

Y'a aussi Clair Obscur: Expedition 33 , le RPG de Sandfall Interactive qui a raflé le Game of the Year aux The Game Awards 2025 (avec 9 prix sur 12 nominations !). Sauf que les Indie Game Awards lui ont retiré ses deux prix parce que le studio avait utilisé de l'IA comme placeholders pendant le dev. Le directeur Guillaume Broche a pourtant été clair : tout dans le jeu final est fait par des humains. Hé bien ça n'a pas suffi !

Et même Larian, les papas de Baldur's Gate 3, se sont pris un shitstorm quand Swen Vincke a confirmé que le studio utilisait l'IA générative pour le concept art et l'exploration d'idées sur le prochain Divinity. Il a dû faire marche arrière après que des ex-employés ont révélé que certains devs étaient contre cette décision en interne. Tout ça pour du concept art qui n'aurait même pas été dans le jeu final !

Perso, je comprends pas que ce soit un débat. Un bon jeu, c'est quoi ? C'est un gameplay qui tient la route, une histoire qui accroche, des mécaniques bien foutues. Pas le fait qu'un humain ait dessiné chaque pixel à la main.

Y'a des tas d'humains qui produisent de la merde tous les jours. Pourquoi ce serait automatiquement meilleur qu'une IA bien pilotée par des gens qui savent ce qu'ils veulent ? Une IA toute seule, ça fait du slop générique. Mais une IA guidée par des créatifs avec une vision ? Ça peut aller plus vite, réduire les coûts, et même permettre d'explorer des trucs qu'on n'aurait jamais tentés autrement.

Les studios qui cèdent à la pression et annulent des projets juste pour prouver qu'ils ont embauché des artistes, je suis pas sûr que ça donne de meilleurs jeux au final. Ça donne juste des jeux qui ont coûté plus cher à produire !

Bref, à la fin il restera que les bons jeux. IA ou pas. Au chiotte le slop IA, et aux chiottes les Angry Gamers qui tuent des projets sur des suppositions à la con !