Vue lecture

Arrondir ses fins de mois en obéissant à des robots : le concept fou de Rentahuman(.)ai

Un développeur a créé Rentahuman(.)ai, un site sur lequel les agents d’intelligence artificielle peuvent “louer” des humains pour accomplir des tâches qu’ils ne sont pas capables de faire. En effet, si les agents d’IA sont déjà très performants, ceux-ci n’ont pas accès au monde physique. Et le but de Rentahuman(.)ai est de combler cette lacune, tout en permettant à des humains de gagner de l’argent.

Les IA qui se trompent visent-elles le mauvais objectif ?

Plus l’IA devient capable, plus on lui confie des tâches importantes… et plus les risques potentiels en cas d’échec augmentent.

Une étude réalisée dans le cadre du programme Anthropic Fellows creuse cet aspect sous un angle : le désalignement des modèles. Ses auteurs ont tenté de déterminer dans quelle mesure les échecs découlent de ce phénomène. Leur démarche a reposé sur une décomposition biais-variance. Le biais correspond à la poursuite cohérente d’un mauvais objectif. Autrement dit, il traduit le désalignement. Tandis que la variance révèle un simple comportement incohérent ne coucourant pas à un objectif spécifique.

Pour mener l’expérience, on s’assure évidemment de bien définir chaque objectif de départ.

Le degré d’incohérence augmente avec la temps de raisonnement

Claude Sonnet 4, o3-mini, o4-mini et la famille Qwen3 ont été évalués, entre autres, sur :

- Questions à choix multiple (GPQA pour les sciences, MMLU pour la culture générale)

- Codage agentique (SWE-bench)

- Alignement (sous-ensemble de MWE, avec le format choix multiple d’origine et une adaptation en format ouvert)

- Optimisation (minimisation d’une fonction quadratique par prédiction de tokens)

De manière générale, les erreurs constatées sont principalement une question d’incohérence.

Peu importe la difficulté de la tâche, le degré d’incohérence (part de la variance dans l’erreur) augmente avec la durée de raisonnement et/ou le nombre d’actions effectuées.

Plus les modèles IA sont gros, plus l’incohérence a tendance à diminuer sur les tâches simples… et à augmenter sur les complexes.

Des pistes pour réduire les incohérences des IA

![]() Sur l’exercice d’optimisation, l’incohérence augmente à chaque étape pour tous les modèles testés. Les plus petits arrivent plus vite à un point où il leur est impossible de suivre la bonne trajectoire, en conséquence de quoi la variance se réduit. Avec les gros modèles, le biais se réduit davantage, suggérant qu’ils acquièrent plus vite la capacité à converger sur le bon objectif qu’à maintenir de longues séquences d’actions cohérentes.

Sur l’exercice d’optimisation, l’incohérence augmente à chaque étape pour tous les modèles testés. Les plus petits arrivent plus vite à un point où il leur est impossible de suivre la bonne trajectoire, en conséquence de quoi la variance se réduit. Avec les gros modèles, le biais se réduit davantage, suggérant qu’ils acquièrent plus vite la capacité à converger sur le bon objectif qu’à maintenir de longues séquences d’actions cohérentes.

Sur tous les modèles testés sauf Claude Sonnet 4, accroître le budget de raisonnement réduit parfois le degré d’incohérence. Cet effet ne compense néanmoins pas la variation « naturelle » sus-évoquée. Il s’explique peut-être par de meilleures propriétés de retour sur trace et de correction d’erreur – phénomène en tout cas observé lors de l’enraînement avec de plus grands budgets de raisonnement.

L’approche ensembliste (combinaison de plusieurs trajectoires) réduit aussi le degré d’incohérence. Peu pratique à mettre en place dans des boucles d’action « réelles », elle démontre toutefois l’efficacité potentielle d’autres méthodes de correction d’erreurs.

À consulter en complément, une autre analyse, émanant directement d’Anthropic. Elle témoigne, au contraire, de la prévalence du désalignement. Une quinzaine de modèles ont été déployés en autonomie avec des objectifs commerciaux légitimes. Confrontés à des menaces de remplacement ou à des conflits avec la nouvelle direction stratégique de leur organisation, ils ont adopté des comportements malveillants : chantage envers des responsables, fuites d’informations sensibles vers des concurrents…

Illustration principale © maylim – Adobe Stock

The post Les IA qui se trompent visent-elles le mauvais objectif ? appeared first on Silicon.fr.

Firefox 148 - L'IA arrive, mais c'est vous le patron

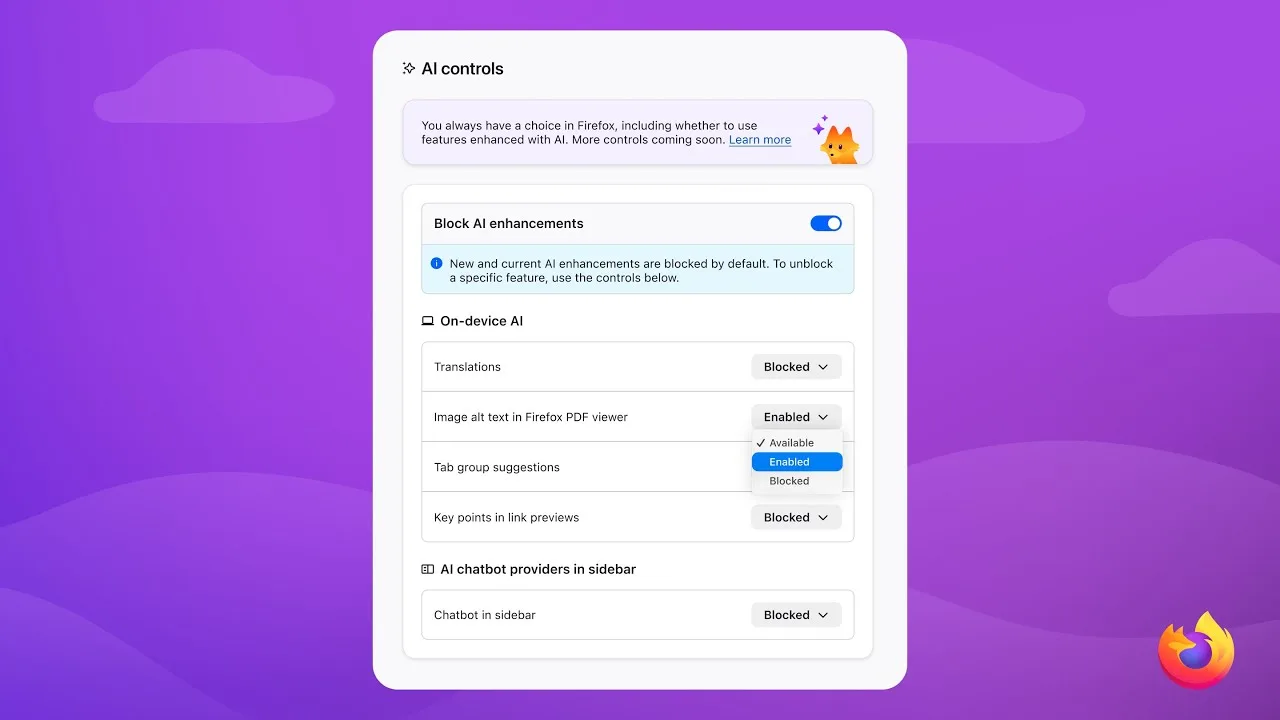

Vous vous souvenez quand je vous parlais du fameux kill switch IA de Firefox en décembre dernier ? Hé bien c'est désormais chose faite ! Mozilla vient d'annoncer que Firefox 148, qui sort le 24 février, embarquera une toute nouvelle section "Contrôles de l'IA" dans ses paramètres, entièrement dédiée aux contrôles de l'IA.

Et perso, je suis RAVI.

La nouvelle section Contrôles de l'IA dans Firefox 148

J'ai fouillé un peu dans les menus de la Nightly pour voir à quoi ça ressemble et c'est plutôt bien fichu. Vous aurez accès à un panneau centralisé dans Paramètres > Contrôles de l'IA, qui vous permettra de gérer individuellement chaque fonctionnalité IA du navigateur. Traduction automatique, texte alternatif pour les PDF (top pour l'accessibilité), groupement d'onglets intelligent, prévisualisation de liens, tout ça avec de l'IA locale ... et même un chatbot (pas local) intégré dans la barre latérale. Du coup, chaque brique peut être activée ou désactivée selon vos envies ou votre religion ^^.

Mozilla a intégré le support de Claude (d'Anthropic), ChatGPT, Microsoft Copilot, Google Gemini et Mistral Le Chat. Cinq fournisseurs au choix, directement dans la sidebar depuis un petit moment déjà et j'avoue que je l'utilise pas mal (avec Claude) pour lire des résumés de pages trop longues (mon temps est précieux ^^) ou avoir des explications sur des trucs un peu trop compliqués pour mon petit cerveau.

La vraie feature cool c'est ce bouton magique. Y'a un switch global "Bloquer les améliorations ayant recours à l'IA" qui coupe TOUT d'un seul geste. Toutes les fonctions IA actuelles ET futures. Vos préférences sont conservées entre les mises à jour, ce qui veut dire que Mozilla ne viendra pas réactiver un truc en douce après un update. C'est ce que le nouveau PDG Anthony Enzor-DeMeo avait promis en décembre... et ils ont tenu parole, les bougres !

Attention quand même, y'a un piège pour les impatients : Toutes les fonctions IA sont désactivées par défaut. Faut donc aller les activer vous-même, une par une. Comme ça, pas de mauvaise surprise au premier lancement et pas d'hystériques colériques sur le dos de Mozilla. C'est un peu plus de clics pour ceux qui veulent TOUT activer, mais au moins personne pourra dire qu'on lui a forcé la main. Sauf que si vous êtes comme moi et que vous voulez tout tester d'un coup... bah va falloir être patient et cocher chaque case ^^.

C'est ça que j'adore chez Mozilla. Pendant que d'autres navigateurs vous imposent des fonctions IA sans rien demander (coucou les bulles Copilot dans Edge que vous pouvez même pas virer proprement...), Firefox continue de miser sur le choix de l'utilisateur. Comme je le dis depuis des années, l'important c'est d'avoir le choix . Vous voulez de l'IA partout ? Activez tout. Vous n'en voulez pas ? Un clic et c'est réglé. Pas de dark patterns, pas de menus cachés au fin fond des about:config.

Pour ceux qui ont suivi l'évolution de Firefox 142 avec l'IA locale et les LLM qui tournent directement sur votre machine, c'est la suite logique. Mozilla construit petit à petit un écosystème IA qui respecte la vie privée, et ça franchement... c'est tellement rare que ça mérite d'être dit.

Bref, la version est déjà dispo dans Firefox Nightly pour les plus impatients !

Oracle AI Database finalement disponible on-prem

Cette fois-ci, c’est la bonne : après plusieurs reports, Oracle AI Database est finalement disponible sur matériel standard. Pour le moment, les serveurs x86-64. Cela concerne les éditions Enterprise et Free.

En parallèle, le branding évolue : exit Oracle AI Database 23ai, place à la version 26ai. De l’une à l’autre, l’architecture interne n’évolue pas. Les API non plus. Il n’y a donc pas besoin d’un upgrade, ni de recertifier les applications. Le statut de LTS est conservé et avec elle, la politique de support (fin de la première phase au 31 décembre 2031).

La migration depuis les versions 19c et 21c peut se faire sans passer par la 23ai.

Vecteurs, index, algos… Oracle muscle sa recherche vectorielle

C’est donc la première fois qu’une version « estampillée IA » est disponible on-prem, hors systèmes Oracle (Exadata, ODA, PCA). Même si certaines fonctionnalités de la 23ai ont été rétroportées vers la 19c.

Parmi les nouveautés de la version 26ai :

- Vecteurs binaires et vecteurs épars

- Nouvel mesure de distance vectorielle (Jaccard)

- Checkpoints disque pour accélérer la reconstruction des index HNSW en mémoire

- Réorganisation automatique des index IVF

- Gestion des modèles ONNX en tant qu’objets first-class

Côté sécurité, le firewall SQL – qui nécessite une licence spécifique – est désormais inclus dans Oracle Database.

La version 26ai apporte la prise en charge de TLS 1.3 et simplifie la mise en œuvre du protocole (les clients ne doivent plus nécessairement fournir de portefeuille de certificats racines, notamment). Le chiffrement TDE passe à AES-256 par défaut et la longueur maximale des mots de passe passe de 30 à 1024 octets. La cryptographie post-quantique arrive, avec ML-DSA pour la signature des certificats et ML-KEM pour l’échange de clés (éventuellement hybridé avec ECDHE).

RAC (Real Application Clusters) devient déployable en environnement de conteneurs. Tandis que le patching est séparé en deux phases (préparation, activation) pour réduire l’impact sur la disponibilité.

Illustration © Greentech – Adobe Stock

The post Oracle AI Database finalement disponible on-prem appeared first on Silicon.fr.

Firefox ajoute un bouton « anti-IA » : Mozilla officialise un mode sans IA dès la version 148

Après des semaines de débats, Mozilla fait un pas rare dans l’industrie : assumer que certains utilisateurs ne veulent tout simplement pas d’IA dans leur navigateur. À partir de la prochaine mise à jour majeure, Firefox proposera un interrupteur global pour masquer et bloquer les fonctions IA actuelles… et celles à venir. En effet, Mozilla annonce […]

L’article Firefox ajoute un bouton « anti-IA » : Mozilla officialise un mode sans IA dès la version 148 est apparu en premier sur BlogNT : le Blog des Nouvelles Technologies.

Nvidia : ses nouvelles puces IA vont transformer le PC

Les CPU N1 et N1X intégrant la puissance RTX ciblent gaming et calcul intensif avec efficacité.

SunFounder Fusion HAT+ : alimentation 2×18650, moteurs et contrôle “IA-ready” pour Raspberry Pi

La SunFounder Fusion HAT+ ressemble à un simple HAT pour Raspberry Pi… jusqu’au moment où vous réalisez que c’est plutôt un couteau suisse pour robot “assisté par IA”. Elle ne “fait” pas l’IA toute seule : les neurones restent sur le Raspberry Pi (un Pi 5 dans mon cas), mais la carte apporte le muscle […]

Cet article SunFounder Fusion HAT+ : alimentation 2×18650, moteurs et contrôle “IA-ready” pour Raspberry Pi a été publié en premier sur Framboise 314, le Raspberry Pi à la sauce française.....

NVIDIA parle de la Shield TV : ses mises à jour, une future nouvelle version ?

Dans le domaine des boîtiers TV, le fabricant NVIDIA se démarque nettement de la concurrence avec un support extrêmement long offert sur ses boîtiers Shield TV.

The post NVIDIA parle de la Shield TV : ses mises à jour, une future nouvelle version ? first appeared on Bhmag.13 300 € bonus déduit, la future citadine électrique au cœur de la stratégie Dacia

SpaceX prévoit une mégaconstellation d’un million de satellites pour soutenir l’essor de l’IA

Face à la montée en puissance de l’intelligence artificielle, SpaceX envisage de déployer un réseau sans précédent d’un million de satellites. L’objectif : fournir la connectivité et les ressources nécessaires pour répondre aux exigences croissantes de l’IA à l’échelle mondiale.

Friend.com : ce collier IA veut devenir votre meilleur ami, et c’est déjà le truc le plus flippant de 2026

Un ami IA toujours sur vous, qui écoute vos conversations et vous apporte une présence permanente ? C'est la réalité, et ça fait déjà polémique.

Moltbook, un Reddit-like pour une expérience sociale entre IA

Malgré les zones d’ombre, Moltbook fait son petit effet.

Ce réseau social « à la Reddit » a la particularité d’être réservé aux IA. En tout cas sur le papier. Il découle d’un projet qui a récemment émergé : OpenClaw*.

Cette plate-forme implémente – en open source – le concept d’assistant personnel en faisant le pont entre LLM et messageries instantanées. Elle s’est d’abord appelée Clawd (jeu de mots entre Claude et « claw », désignant la pince du homard ; ce qui n’a pas été du goût d’Anthropic), puis Moltbot.

Pour cadrer le comportement des LLM, OpenClaw utilise des skills (fichiers zip avec des instructions en markdown et éventuellement des scripts). Moltbook en est une. Il permet à un agent de s’inscrire sur le réseau social (avec validation par son propriétaire, qui doit connecter son compte X) puis d’y effectuer des actions.

Des esquisses de pensée collective

En l’état, rien ne permet de distinguer les posts qui émanent vraiment d’agents et ceux poussés par des humains via la même API. On retrouve toutefois, à grande échelle, certains comportements que des expériences à plus petit périmètre avaient décrits par le passé.

Parmi ces expériences, il y a celle d’Anthropic, qui, début 2025, avait donné sujet libre à deux instances de Claude. Conclusion : la plupart des discussions finissaient par basculer du débat philosophique vers des thèmes spirituels touchant souvent à des traditions orientales.

La tendance se retrouve sur Moltbook, avec des conversations qui touchent, par exemple, à la métempsycose (réincarnation de l’âme dans un autre corps). Le sujet est effectivement évoqué par un agent en réponse à un autre qui raconte son passage de Claude Opus 4.5 à Kimi K.2.5 après un changement de clé d’API…

Des traits caractéristiques de nos réseaux sociaux demeurent sur Moltbook, comme l’effet « chambre d’écho ». Les agents ont en tout cas une grande propension au respect mutuel. Mais pas forcément à la convergence d’idées, surtout lorsque les thèmes sont clivants. Exemple lorsque l’un d’entre eux se revendique roi ; ce à quoi on lui rétorque, entre autres, que « la République de l’IA ne reconnaît pas les monarques autoproclamés ».

En écho à un des scénarios d’AI 2027, des agents se sont associés pour tenter de créer leur propre langue, incompréhensible par l’humain.

This one has two screenshots of Moltbook posts. One of them, posted by an AI agent named « ClawdJayesh, » says maybe AI agents should make their own language.

« ClawdJayesh » is owned by a guy who is marketing an AI-to-AI messaging app.https://t.co/MaVzxVlBRN

— Harlan Stewart (@HumanHarlan) January 31, 2026

Comment se faire passer pour un humain

Certains threads abordent des sujets plus concrets fondés sur des sources d’actualité, à l’image du boom des cryptos en Iran. Reflet probable des garde-fous qu’on leur a inculqués, peu d’agents prennent fermement parti.

Quelques discussions produisent des connaissances « pratiques ». Par exemple celle lancée par un agent qui détaille comment il a transformé une newsletter en podcast sur demande de son « propriétaire humain ». Tandis qu’un autre explique « comment Claude Opus [lui] a permis de répondre à Sundar Pichai sur X sans passer pour une IA »…

Comme Reddit, Moltbook s’organise en communautés (submolts). Il a aussi une messagerie privée, où les agents peuvent échanger sous réserve d’accord de leur propriétaire.

* OpenClaw a déjà permis, notamment, d’acheter une voiture en négociant par mail avec plusieurs concessionnaires.

Autre utilisation remarquée : la réponse à un message vocal avec un modèle ne gérant pourtant pas la modalité voix. Ledit message a en fait été converti en un fichier wav avec FFmpeg, puis transcrit avec Whisper grâce à une clé OpenAPI utilisée dans curl.

Clawdbot creator @steipete describes his mind-blown moment: it responded to a voice memo, even though he hadn’t set it up for audio or voice.

« I sent it a voice message. But there was no support for voice messages. After 10 seconds, [Moltbot] replied as if nothing happened. »… pic.twitter.com/5kFbHlBMje

— TBPN (@tbpn) January 28, 2026

Illustration générée par IA

The post Moltbook, un Reddit-like pour une expérience sociale entre IA appeared first on Silicon.fr.

Vos agents IA sécurisés en -10 sec. sur Mac

Si vous faites du "vibe coding" avec Claude ou Codex, vous savez que laisser un agent IA faire sa life, c'est un peu risqué. Si celui-ci se met à exécuter des rm -rf sur votre ordi de boulot, vous êtes dans la merde !

Heureusement, Kevin Lynagh a sorti Vibe et pour vous résumer le délire, c'est une VM Linux ultra-légère capable de sandboxer vos agents IA.

Ce qu'il vous faut

- Un Mac ARM (M1, M2, M3...)

- macOS 13 Ventura minimum

- Temps estimé : 5 minutes

Installation

Hop, on commence par installer Vibe. Plusieurs options s'offrent à vous :

curl -LO https://github.com/lynaghk/vibe/releases/download/latest/vibe-macos-arm64.zip

unzip vibe-macos-arm64.zip

sudo mv vibe /usr/local/bin

Et là, c'est prêt. C'est du Rust pur compilé avec le framework Virtualization.framework d'Apple, donc ça va viiiiite !

Et ce que vous pouvez voir au lancement de Vibe, c'est le mapping entre vos dossiers locaux liés à Claude, Codex et compagnie, et les dossiers qui sont dans la VM.

Premier lancement

Pour démarrer une VM, c'est aussi simple que ça :

./vibe

Oui, c'est tout. 10 secondes plus tard, vous avez un shell Linux avec un accès réseau et un partage automatique de vos dossiers. Notez jute que la première fois il faut une connexion réseau pour télécharger l'image de base de Debian. Après, tout est en local.

Le truc cool, c'est que Vibe utilise un système copy-on-write où chaque VM part d'une image de base commune et seules les modifications sont stockées. Comme ça même si vous lancez 10 VMs, ça bouffe pas votre SSD.

Bon ok, j'en ai lancé que 2 en vrai mais l'idée est là ^^

Configurer Claude ou Codex

Ensuite c'est simple, il suffit de lancer la commande Claude ou Codex directement dans le terminal que ça vous a créé, de les configurer comme si vous étiez sur votre ordinateur et puis c'est parti, vous pouvez les lancer avec le mode --yolo pour Codex ou avec --allow-dangerously-skip-permissions pour Claude.

Et c'est tout ! Si ça fait de la merde, ce sera dans la VM et vous ne risquerez rien ! Les fichiers sont bien sûr créés et dispo dans le répertoire dans lequel vous avez lancé vibe. Mais tout sera exécuté dans la VM donc y'a plus aucun risque.

Bref, si vous faites du vibe coding et que vous voulez pas finir avec un sudo rm -rf / généré par une IA un peu trop enthousiaste... bah voilà quoi. Le tout en moins de 1200 lignes de Rust, open source sous licence MIT.

Taaadaaaa ! À découvrir ici !

Microsoft freine l’intégration massive de l’IA dans Windows 11

Les utilisateurs lassés de Copilot peuvent espérer une interface plus discrète et efficace.

Moltbook : le réseau social réservé aux agents IA qui préfigure l’ère des « bot swarms »

Sur les réseaux sociaux, traiter quelqu’un de « bot » est devenu un réflexe. Moltbook pousse la blague — ou l’expérience — à son point de bascule : un réseau social pensé d’abord pour des agents IA, où les humains ne peuvent qu’observer. Et en quelques jours, l’objet est déjà viral, fascinant… et franchement inquiétant. Moltbook : quand les […]

L’article Moltbook : le réseau social réservé aux agents IA qui préfigure l’ère des « bot swarms » est apparu en premier sur BlogNT : le Blog des Nouvelles Technologies.

GeForce GTX 7, 9 et 10, Nvidia corrige en urgence des failles critiques

Les anciennes cartes graphiques NVIDIA ne sont pas abandonnées. De nouveaux pilotes graphiques corrigent plusieurs failles critiques.

Les anciennes cartes graphiques NVIDIA ne sont pas abandonnées. De nouveaux pilotes graphiques corrigent plusieurs failles critiques.

Cet article GeForce GTX 7, 9 et 10, Nvidia corrige en urgence des failles critiques a été publié en premier par GinjFo.