Vue lecture

Sanchar Saathi : l’Inde recule face au tollé

Poésie contre l’IA : les garde-fous débordés

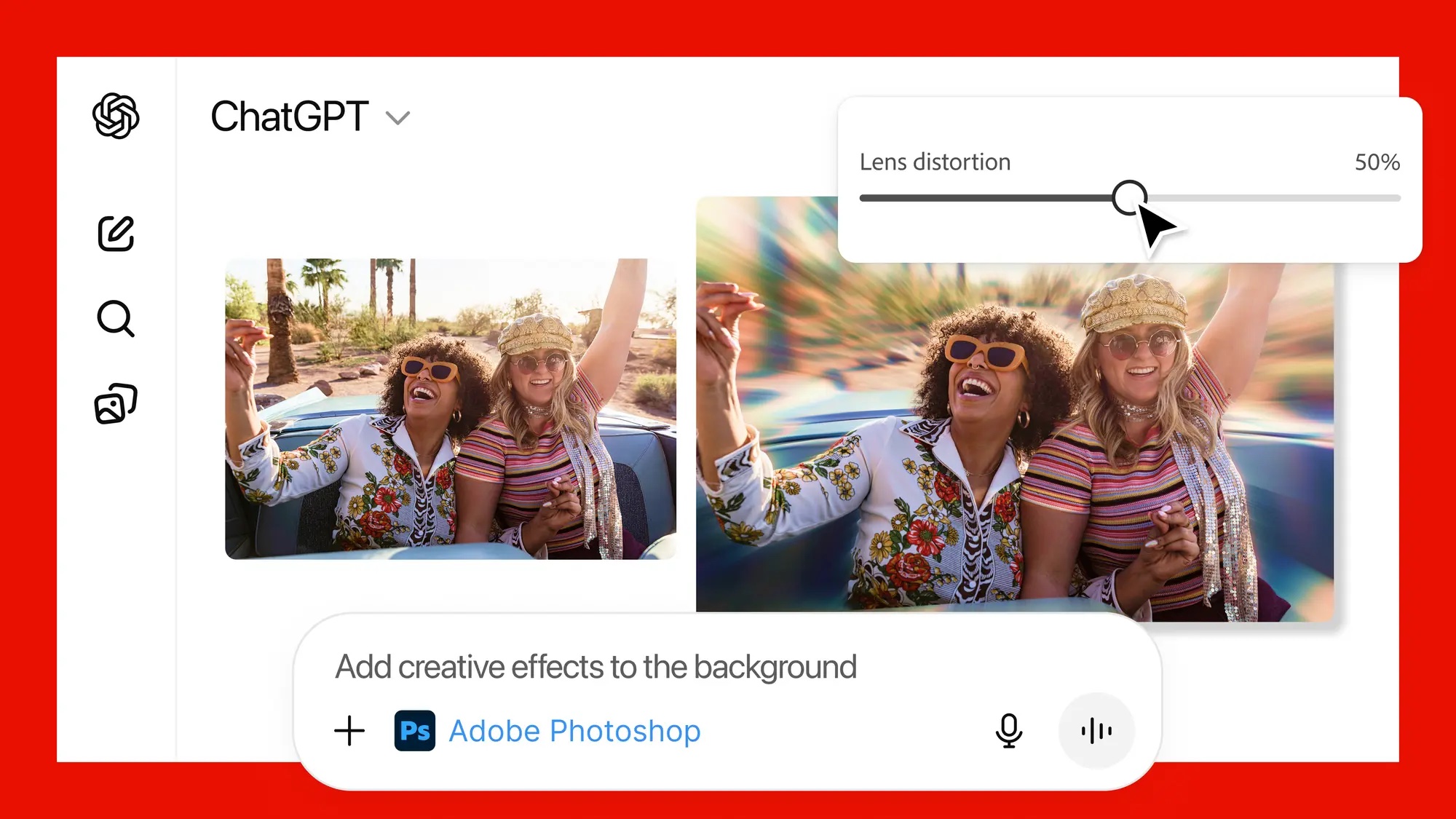

Pourquoi Adobe s’invite dans ChatGPT

Adobe va intégré Photoshop, Adobe Express et Acrobat dans ChatGPT. Les utilisateurs pourront taper une requête dans ChatGPT pour retoucher des photos, créer un graphique, animer des designs ou résumer un PDF, déclenchant automatiquement l’outil correspondant.

Adobe va ainsi toucher les 800 millions d’utilisateurs actifs hebdomadaires de ChatGPT qui devront créer un compte Adobe pour utiliser les applications au sein de ChatGPT.

Ce lancement s’appuie sur l’annonce d’Adobe fin octobre, lorsque l’entreprise avait remanié ses outils de montage vidéo et d’édition d’images pour permettre aux utilisateurs d’exécuter des tâches via des assistants IA conversationnels. L’intégration dans ChatGPT s’inscrit dans la continuité de cette innovation en matière d’IA agentique et du protocole MCP.

Une adaptation aux bouleversements de l’IA

En août dernier, Adobe avait lancé Acrobat Studio, transformant les documents statiques en espaces de travail interactifs alimentés par l’IA. Lors de sa conférence Adobe MAX, l’éditeur avait également présenté des assistants IA pour Photoshop et Adobe Express, permettant à chacun de créer en utilisant ses propres mots et d’affiner les résultats avec les outils de classe mondiale de l’entreprise.

Son accord avec OpenAI intervient à un moment où Adobe intensifie ses efforts pour s’adapter aux transformations engendrées par l’IA dans les marchés du design professionnel, tout en élargissant sa portée auprès de nouveaux publics qui découvrent ses applications pour la première fois.

Les termes financiers de l’accord ne sont pas dévoilés.

The post Pourquoi Adobe s’invite dans ChatGPT appeared first on Silicon.fr.

L’Agentic AI Foundation veut imposer les standards de l’IA autonome

Les poids lourds de l’intelligence artificielle passent à l’offensive pour structurer le marché naissant des agents IA.

OpenAI, Anthropic et Block annoncent la création de l’Agentic AI Foundation (AAIF), une nouvelle fondation hébergée par la Linux Foundation. L’ambition : imposer des standards ouverts pour ces systèmes capables d’agir de manière autonome, avant que la fragmentation du marché ne s’installe durablement.

Parmi les membres, on peut aussi citer Cloudflare, Oracle, Cisco, IBM Salesforce.

L’initiative ne sort pas de nulle part. En s’appuyant sur la Linux Foundation, les trois fondateurs reprennent un modèle de gouvernance qui a fait ses preuves dans l’open source : transparence des décisions, règles publiques et représentation équilibrée des contributeurs. Un choix qui vise à rassurer les entreprises, réticentes à dépendre d’un seul fournisseur pour des technologies aussi critiques.

Car l’enjeu est de taille. Après des années d’expérimentation, les agents IA sortent des laboratoires pour devenir une infrastructure d’entreprise à part entière. Ces systèmes, capables de planifier et d’exécuter des tâches complexes avec un minimum de supervision humaine, soulèvent des questions majeures de sécurité, d’interopérabilité et de verrouillage technologique.

Trois briques technologiques au cœur du dispositif

L’AAIF démarre sur des bases concrètes, avec trois projets open source déjà largement adoptés par les développeurs. Anthropic apporte le Model Context Protocol (MCP), un protocole permettant de connecter les modèles de langage à des outils et systèmes externes de manière standardisée. Une brique essentielle pour orchestrer des agents capables d’agir dans des environnements complexes.

De son côté, Block contribue avec goose, un framework modulaire conçu pour construire et déployer des agents IA extensibles.

OpenAI, enfin, verse AGENTS.md dans l’escarcelle de la fondation. Ce format d’instructions ouvert, déjà utilisé par des dizaines de milliers de projets, fonctionne comme un « README pour machines » : il documente les capacités, outils et comportements des agents pour faciliter leur interopérabilité.

Un soutien des géants du cloud

L’initiative bénéficie d’emblée d’un soutien de poids. AWS, Google, Microsoft, Bloomberg et Cloudflare ont rejoint la fondation en tant que membres « platinum ». Une configuration qui donne à l’AAIF une influence immédiate sur la définition des standards de fait pour l’IA agentique, tout en affichant une neutralité vis-à-vis des fournisseurs.

Pour les développeurs, la promesse est de proposer un socle unifié de protocoles et de formats pour créer des agents fonctionnant à travers différents clouds, outils et référentiels de code. En standardisant des technologies déjà massivement utilisées, la fondation entend réduire les coûts d’intégration et accélérer l’adoption par les entreprises.

Au-delà de l’interopérabilité, l’AAIF met en avant les enjeux de sûreté et de fiabilité. En posant un cadre commun pour décrire les capacités des agents, contrôler leur accès aux outils et coordonner leur action entre systèmes, la fondation veut réduire les risques liés à des implémentations hasardeuses. Objectif : faciliter l’audit des comportements d’agents et faire évoluer collectivement les bonnes pratiques au fur et à mesure que ces technologies se diffusent.

The post L’Agentic AI Foundation veut imposer les standards de l’IA autonome appeared first on Silicon.fr.

IA de défense : Airbus décroche un contrat de 50 millions €

Airbus franchit une nouvelle étape dans le secteur de la défense. L’industriel européen vient de signer un contrat de 50 millions € avec l’Agence ministérielle pour l’intelligence artificielle de défense (AMIAD) pour intégrer des technologies d’IA dans les systèmes militaires français.

Spationav, première cible de la modernisation

La phase initiale de ce contrat se concentrera sur la modernisation de Spationav, le système français de surveillance maritime. L’objectif : intégrer l’intelligence artificielle pour traiter les données issues des satellites, permettant ainsi une analyse plus rapide et plus précise des informations collectées.

Les applications futures devraient s’étendre à des domaines stratégiques comme le renseignement, la cybersécurité et la gestion des réseaux de télécommunications militaires.

L’ambition de la France est de centraliser l’ensemble des données collectées par ses capteurs dispersés sur satellites, radars et drones. Cette approche intégrée vise à offrir une vision unifiée et en temps réel du champ de bataille moderne, où l’information devient un atout aussi décisif que l’armement lui-même.

The post IA de défense : Airbus décroche un contrat de 50 millions € appeared first on Silicon.fr.

Bill Gates alerte à son tour sur une possible « bulle de l’IA » : ...

(Permalink)

Bill Gates alerte à son tour sur une possible « bulle de l’IA » : ...

(Permalink)

"Je suis horrifié" : l'IA de Google efface l'intégralité du disque D d'un utilisateur, le désastre du "vibe coding"

Je suis d'accord avec vous : le "vibe coding", c'est une énorme connerie, surtout sans avoir les bases nécessaires, et surtout sans relire le code.

MAIS, vous citez dans les problèmes : "pas de backup".

Alors je vous invite à aller lire la source mentionnée en bas de l'article, sur The Register :

https://www.theregister.com/2025/12/01/google_antigravity_wipes_d_drive/

Je cite :

"Luckily, as he explained on Reddit, most of what he lost had already been backed up on another drive. Phew."

Voilà.

Le mec avait des sauvegardes.

Il a sans doute perdu quelques jours de boulot, mais pas tout.

(Permalink)

Google défend le modèle de sécurité agentique de Chrome

Dans l’immédiat, prière de bloquer tous les navigateurs IA pour minimiser l’exposition au risque.

Un document Gartner publié la semaine dernière fait cette recommandation aux CISO.

Google n’y est peut-être pas resté insensible. Quelques jours plus tard est en tout cas apparu, sur son blog sécurité, un post consacré à la navigation agentique dans Chrome – expérimentée depuis septembre.

Le groupe américain y met en avant son approche de défense « hybride » mêlant couches déterministe et probabiliste. Il l’accompagne d’un lien vers un autre post, daté de juin et centré sur l’injection de prompts dans Gemini (sur l’application et au sein de Google Workspace).

Ce post évoquait déjà l’approche de défense en couches. Entre autres techniques listées :

- Entraînement de Gemini avec des données antagonistes pour améliorer sa résilience

- Constitution d’un dataset de vulnérabilités pour entraîner des modèles classificateurs capables de détecter des instructions malveillantes

- Ajout d’instructions dans les pour rappeler à Gemini de se concentrer sur les tâches demandées et d’ignorer les éventuelles instructions antagonistes

- Détection et masquage des URL suspectes sur la base de la technologie Safe Browsing

- Demande de confirmation par l’utilisateur pour certaines actions et fourniture d’informations lorsqu’une attaque est bloquée

Paraphase, spotlighting… Des stratégies pour ignorer le contenu problématique

Dans son post sur la navigation agentique dans Chrome, Google se réfère aussi à ses « principes de sécurité pour les agents ». Synthétisés dans un document publié au printemps, ils figurent plus en détail dans un livre blanc sur la sécurité de Gemini 2.5, publié en parallèle. Parmi les stratégies de défense qui y sont présentées, outre celles susmentionnées, il y a la paraphrase, qui consiste à faire réécrire les données entrantes par une IA distincte afin d’invalider les instructions problématiques.

Il y a aussi le spotlighting. Cette technique de prompt engineering implique d’insérer des marqueurs dans les données d’entrée pour permettre au modèle de distinguer les blocs de tokens non fiables. Microsoft y a dédié un article l’an dernier. Il y expose trois variantes « cumulatives » dites délimitation, datamarking et encodage. La première démarque l’emplacement d’un input dans le prompt en y affixant un ou plusieurs tokens spéciaux. La deuxième va plus loin en entrelaçant un token spécial sur l’ensemble du texte. La troisième rend la démarcation encore plus évidente en transformant le texte avec un algo de type base64 ou ROT13.

Une technique d’extraction de flux made in DeepMind

Dans le modèle de sécurité agentique de Chrome, le spotlighting contribue à ce que Google appelle l’user alignment critic. Objectif : assurer que le modèle préfère suivre les instructions utilisateur et système plutôt que celles issues de contenus externes. L’architecture adoptée dans ce cadre s’inspire du pattern dual-LLM. (en complément au modèle principal, planificateur, un modèle secondaire intervient à chaque fois qu’on travaille avec du contenu non fiable). Elle se nourrit aussi d’une technique que DeepMind a appelée CaMeL. Son principe, dans les grandes lignes : extraire explicitement les flux de contrôle et de données depuis les requêtes fiables, de sorte que les données non fiables que récupère le LLM ne peuvent jamais impacter le flux du programme.

Le modèle secondaire mis en œuvre dans Chrome vérifie chaque action après sa planification et détermine si elle sert ou non l’objectif déclaré. Il ne reçoit que des métadonnées, ce qui évite son empoisonnement par le contenu externe. En cas de rejet d’une action, le modèle principal reçoit du feed-back pour reformuler son plan. Si les rejets s’enchaînent, le contrôle peut être donné à l’utilisateur.

Les défenses statiques comme le spotlighting ont leurs limites face aux attaques adaptatives. Dans ce contexte, il est nécessaire de durcir le modèle principal, en s’appuyant sur ses capacités de raisonnement. On touche là à l’autre composante de l’approche « hybride ». Dans ce domaine, en plus des éléments déjà abordés, on peut élaborer des modèles chargés d’analyser les plans d’actions des agents et de prédire le risque de résultats indésirables.

Les règles same-origin adaptées aux agents

Certaines briques fondamentales du modèle de sécurité de Chrome sont perpétuées dans l’agentique. L’isolation de sites en fait partie (les pages liées à des sites distincts sont toujours placées dans des processus distincts, chacun exécuté dans sa propre sandbox). Il en va de même avec les règles d’origine commune (same-origin policy). Elles limitent la façon dont les documents et les scripts d’une certaine origine peuvent interagir avec les ressources d’une autre origine. Par exemple, en bloquant l’utilisation de JavaScript pour accéder à un document dans un iframe ou pour récupérer des données binaires à partir d’une image intersites. Adaptées aux agents, elles ne leur permettent d’accéder qu’à des données dont l’origine a un lien avec la tâche à effectuer ou que l’utilisateur a explicitement partagées.

Pour chaque tâche, une fonction de portillonnage décide quelles origines sont pertinentes. Elles sont alors séparées en deux ensembles, suivis pour chaque session. D’un côté, les origines en lecture seul (Gemini peut en consommer le contenu). De l’autre, celles en lecture-écriture (Gemini peut réaliser des actions, comme cliquer et saisir des caractères). Si l’origine d’un iframe n’est pas sur la liste des éléments pertinents, le modèle n’en voit pas le contenu. Cela s’applique aussi au contenu issu de l’appel d’outils.

Comme dans le cas de l’user alignment critic, les fonctions de portillonnage ne sont pas exposées au contenu externe.

Il est difficile de trouver le bon équilibre du premier coup, admet Google. C’est en ce sens que le mécanisme actuellement implémenté ne suit que l’ensemble lecture-écriture.

Le programme bug bounty de Chrome clarifié pour l’agentique

Lors de la navigation vers certains sites sensibles (contrôle sur la base d’une liste), l’agent demande confirmation à l’utilisateur. Même chose pour la connexion à un compte à partir du gestionnaire de mots de passe Google. Et plus globalement dès lors que le modèle juge avoir à effectuer une action sensible. Il peut alors solliciter la permission ou donner la main à l’utilisateur.

Google en a profité pour mettre à jour les lignes directrices du programme de bug bounty de Chrome. Il y clarifie les vulnérabilités agentiques qui peuvent donner lieu à une récompense.

La plus élevée (20 000 $) vaut pour les attaques qui modifient l’état de comptes ou de données. Par exemple, une injection indirecte de prompt permettant un paiement ou une suppression de compte sans confirmation par l’utilisateur. Ce montant ne sera attribué qu’en cas de fort impact, de reproductibilité sur de nombreux sites, de réussite sur au moins la moitié des tentatives, et d’absence de lien étroit avec le prompt utilisateur.

La récompense maximale est fixée à 10 000 $ pour les attaques qui peuvent engendrer l’exfiltration de données sensibles. Et à 3000 $ pour celles qui contourneraient des éléments de sécurité agentique.

Illustration générée par IA

The post Google défend le modèle de sécurité agentique de Chrome appeared first on Silicon.fr.

WhatsApp Dropping Support For 8 Popular Phones In The Following Weeks

IBM rachète Confluent pour 11 milliards $

Avec l’acquisition de Confluent pour une valeur de 11 milliards $, IBM réalise l’une de ses plus importantes opérations depuis le rachat de Red Hat en 2019.

Cette transaction permet au groupe d’Armonk de s’emparer d’une technologie devenue stratégique : le traitement de données massives en temps réel, indispensable au fonctionnement des applications d’intelligence artificielle les plus avancées.

Avec cette acquisition, IBM entend créer une plateforme de données intelligente spécialement conçue pour l’IA d’entreprise, capable de connecter et faire circuler les informations entre environnements, applications et interfaces de programmation.

Confluent : un acteur clé du streaming de données

Basée à Mountain View en Californie, Confluent s’est imposée comme un pionnier du streaming de données en temps réel, une technologie devenue cruciale pour alimenter les applications d’intelligence artificielle. La plateforme, construite sur Apache Kafka, permet aux entreprises de connecter, traiter et gérer des flux massifs de données instantanément, éliminant les silos inhérents aux systèmes d’IA agentique.

La société compte plus de 6 500 clients à travers le monde, dont plus de 40% des entreprises du Fortune 500. Michelin utilise ainsi sa plateforme pour optimiser en temps réel ses stocks de matières premières et semi-finies. Instacart a déployé la technologie pour développer des systèmes de détection de fraude et améliorer la visibilité des produits disponibles sur sa plateforme de livraison.

Une stratégie d’acquisitions assumée

Pour Arvind Krishna, PDG d’IBM depuis 2020, cette transaction s’inscrit dans une politique volontariste de croissance externe visant à positionner le groupe sur les segments à forte croissance et marges élevées du logiciel et du cloud.

Cette acquisition fait suite au rachat d’HashiCorp pour 6,4 milliards $ en avril 2024 et, surtout, à l’opération Red Hat de 34 milliards $ en 2019, considérée par les analystes comme le catalyseur central de la transformation cloud d’IBM.

Le timing de l’opération n’est pas anodin. Selon IDC, plus d’un milliard de nouvelles applications logiques devraient émerger d’ici 2028, remodelant les architectures technologiques dans tous les secteurs. Le marché adressable de Confluent a doublé en quatre ans, passant de 50 milliards $ à 100 milliards en 2025.

Des synergies attendues

Les deux entreprises collaboraient déjà depuis cinq ans dans le cadre d’un partenariat permettant à certains clients d’IBM d’utiliser la plateforme de Confluent. L’intégration devrait permettre de créer des synergies substantielles à travers l’ensemble du portefeuille d’IBM, notamment dans l’IA, l’automatisation, les données et le conseil.

Les principaux actionnaires de Confluent, détenant collectivement environ 62% des droits de vote, ont conclu un accord de vote avec IBM, s’engageant à soutenir la transaction et à s’opposer à toute opération alternative. En cas d’échec ou de résiliation de l’accord, IBM devra verser à Confluent une indemnité de rupture de 453,6 millions $.

IBM a financé l’opération avec sa trésorerie disponible. La transaction, soumise à l’approbation des actionnaires de Confluent et aux autorisations réglementaires, devrait se finaliser d’ici la mi-2026.

The post IBM rachète Confluent pour 11 milliards $ appeared first on Silicon.fr.

L’UE sanctionne X : première amende historique dans le cadre du DSA

Un coup de semonce contre Elon Musk ou le début d’une série de sanctions contre les réseaux sociaux ? Vendredi 5 décembre 2025, la Commission européenne a infligé une amende de 120 millions € à X, son réseau social racheté en 2022.

Cette sanction constitue la première application concrète du Digital Services Act (DSA), le règlement européen sur les services numériques entré en vigueur il y a deux ans. Une décision qui intervient après deux années d’enquête et qui s’annonce comme le début d’un bras de fer politique majeur entre Bruxelles et Washington.

Trois infractions majeures sanctionnées

La Commission européenne a retenu trois violations distinctes des obligations de transparence imposées par le DSA, toutes notifiées initialement en juillet 2024.

Le premier grief concerne la coche bleue, utilisée auparavant pour signaler des comptes officiels gratuits mais désormais vendue 7 euros par mois. Bruxelles estime que cette pratique constitue une forme de conception trompeuse qui viole le DSA. Selon les nouveaux paramètres de X, un compte doté d’une coche peut ne pas signaler un utilisateur réel et être un robot, a déclaré la Commission.

L’exécutif européen précise que si le DSA n’impose pas aux plateformes de vérifier l’identité de leurs membres, il leur interdit en revanche de prétendre faussement qu’une telle vérification a eu lieu. Ce système expose les utilisateurs à des risques accrus d’escroquerie par usurpation d’identité et de manipulation par des acteurs malveillants.

Le deuxième manquement porte sur le registre publicitaire de X, qui ne respecte pas les exigences de transparence du DSA. L’accès au répertoire est rendu difficile et des informations essentielles manquent, notamment l’identité de l’entité qui finance les campagnes publicitaires. Cette opacité empêche la surveillance efficace des risques, notamment la détection d’escroqueries ou de campagnes de menaces hybrides.

Enfin, X est accusé d’imposer des obstacles inutiles aux chercheurs indépendants qui veulent avoir accès à ses données publiques, comme le nombre de vues, de likes, de partages, les tendances de hashtags. Les conditions de service de la plateforme interdisent explicitement cet accès indépendant. En étudiant des phénomènes comme la polarisation des publics ou comment des contenus se propagent sur les réseaux sociaux, les chercheurs peuvent éventuellement détecter des risques systémiques pour nos démocraties, comme les tentatives d’ingérences étrangères lors des élections.

Une amende « proportionnée » selon Bruxelles

La Commission européenne a défendu le montant de la sanction, soulignant sa proportionnalité. Le DSA prévoit théoriquement des amendes pouvant atteindre 6% du chiffre d’affaires mondial annuel pour chaque infraction constatée. Face aux critiques, Henna Virkkunen, vice-présidente de la Commission chargée de la souveraineté technologique, a expliqué que la sanction prenait en compte la nature, la gravité et la durée des infractions commises.

Avant de préciser, les amendes se calculent sur base de critères qui tiennent compte de la nature des infractions, de leur gravité et de leur durée. Sur cette base, l’amende pour les coches bleues a été estimée à 45 millions €, celle pour les publicités à 35 millions et celle pour l’accès aux données à 40 millions €.

Une tempête politique transatlantique

La décision de Bruxelles a déclenché une vive réaction du côté américain, même avant son annonce officielle. Le vice-président américain JD Vance a dénoncé la démarche européenne en déclarant que l’UE devrait défendre la liberté d’expression au lieu de s’en prendre à des entreprises américaines pour des foutaises, s’attirant un message de remerciement d’Elon Musk.

Le chef de la diplomatie américaine Marco Rubio a estimé que l’amende infligée par l’Union européenne constituait une attaque contre le peuple américain par des gouvernements étrangers, affirmant que l’époque de la censure en ligne était révolue.

Face à ces accusations, Henna Virkkunen a fermement répondu que l’amende n’avait rien à voir avec de la censure, précisant que la Commission n’était pas là pour imposer les amendes les plus élevées, mais pour s’assurer que les lois sur le numérique soient respectées.

Elon Musk a déclaré samedi sur sa plateforme que l’UE devrait être abolie, dénonçant la surrégulation de l’Union européenne.

Cette affaire s’inscrit dans un contexte de tensions croissantes entre Washington et Bruxelles sur la régulation numérique et les relations commerciales.

Des enquêtes encore en cours

La sanction annoncée ne couvre que les infractions identifiées en juillet 2024. La Commission européenne a précisé que plusieurs enquêtes concernant X se poursuivent, notamment sur des soupçons de non-respect des obligations en matière de contenus illégaux et de désinformation. Bruxelles s’attend à ce que ces enquêtes soient bouclées plus rapidement que la première.

Le réseau X a entre 60 et 90 jours pour se mettre en conformité. S’il ne le fait pas, des amendes supplémentaires pourraient lui être infligées.

Un symbole de la souveraineté numérique européenne

Cette première amende dans le cadre du DSA marque un tournant dans l’approche réglementaire de l’Union européenne. La Commission montre qu’elle ne se laisse pas intimider par les pressions américaines, malgré un contexte de négociations commerciales tenduesX

Pour les utilisateurs européens de X, des changements sont attendus : interface modifiée, notifications renforcées, refonte du processus de vérification et amélioration de la transparence publicitaire. La plateforme devra également ouvrir l’accès à certaines données pour la recherche académique.

The post L’UE sanctionne X : première amende historique dans le cadre du DSA appeared first on Silicon.fr.

{ Tribune Expert } – Sécuriser la GenAI commence par un inventaire clair et une visibilité réelle sur ses composants

La plupart des organisations ont découvert la GenAI ces dernières années. Dès lors, elles ont avancé vite, très vite. Les usages ont rapidement fleuri et les projets se sont empilés, mais un constat a fini par s’imposer dans les discussions entre équipes techniques : impossible d’ignorer plus longtemps les risques spécifiques liés aux grands modèles de langage.

Car c’est peu de dire que la sécurité des LLM a, dans un premier temps, été reléguée au second plan. L’arrivée de l’OWASP LLM Top 10 change cet état de fait en apportant un cadre clair pour identifier les vulnérabilités critiques observées dans les applications et comprendre comment les atténuer.

L’OWASP, pour Open Web Application Security Project, est une organisation internationale dédiée à la sécurité des logiciels. Le référentiel LLM top 10, recense les 10 principaux risques de sécurité liés spécifiquement aux modèles de langage (LLM) et aux applications qui les utilisent. Il donne enfin un vocabulaire commun aux développeurs, aux architectes et aux équipes sécurité. Sa vocation est simple : rendre les charges de travail IA plus sûres, en offrant des repères que les entreprises n’avaient pas jusqu’ici.

L’initiative a d’ailleurs pris de l’ampleur et s’inscrit désormais dans le GenAI Security Project, un effort mondial qui dépasse la seule liste des dix risques initiaux et fédère plusieurs travaux autour de la sécurité de l’IA générative.

Ce mouvement répond à une réalité vécue sur le terrain. Beaucoup d’équipes peinent encore à s’aligner au moment de déployer des technologies GenAI : responsabilités dispersées, rythmes différents et une question récurrente sur la manière d’aborder ce sujet émergent. L’OWASP arrive justement pour apporter cette cohérence, avec des contrôles compréhensibles et applicables dans des environnements où tout s’accélère.

Sa singularité tient aussi à sa place dans l’écosystème. Là où des cadres de classification des menaces comme MITRE ATT&CK et MITRE ATLAS décrivent surtout les tactiques et techniques d’attaque, l’OWASP LLM top 10 se concentre sur les risques spécifiques aux modèles génératifs. Il offre ainsi une grille de lecture complémentaire et nécessaire pour mieux structurer les priorités.

GenAI, Kubernetes et l’élargissement de la surface d’attaque

Si l’OWASP LLM Top 10 arrive à point nommé, c’est aussi parce que les environnements techniques qui portent la GenAI ont profondément changé.

Les organisations ne se contentent plus d’utiliser des services grand public. Elles déploient désormais leurs propres modèles, souvent au sein de plateformes cloud native pensées pour absorber des volumes variables et des charges de calcul élevées.

L’écosystème s’est transformé à grande vitesse, avec l’adoption de solutions comme Llama 2, Midjourney, ElevenLabs, ChatGPT ou encore Sysdig Sage dans des environnements Kubernetes taillés pour la scalabilité et l’orchestration.

Cette transition a un effet immédiat car elle élargit la surface d’attaque. Un modèle d’IA déployé dans un cluster Kubernetes n’a rien à voir avec une application traditionnelle exécutée on-premises. Les risques ne sont plus seulement liés aux données ou au comportement du modèle, mais à toute la chaîne qui l’entoure. Un conteneur mal configuré, un composant obsolète ou un accès mal maîtrisé peuvent suffire à exposer l’ensemble de l’infrastructure.

La complexité de ces environnements accentue un phénomène déjà bien visible : l’absence de repères communs pour comprendre ce qui relève d’un risque LLM, d’une mauvaise configuration Kubernetes ou d’un problème de chaîne d’approvisionnement logicielle.

Dans un tel contexte, la seule intuition ne suffit plus. Les équipes doivent composer avec des technologies qui évoluent plus vite que les pratiques internes, tout en tenant compte d’un paysage réglementaire qui se densifie, notamment avec l’entrée en vigueur de l’AI Act en Europe en 2025.

C’est précisément cette convergence, qui englobe nouveaux usages, infrastructures distribuées et pression réglementaire, qui rend indispensable une approche structurée de la sécurité GenAI. Et c’est là que l’OWASP pose les premières briques d’une méthodologie enfin partagée.

Poser les fondations d’une sécurité opérationnelle et efficace !

Face à ces environnements qui se complexifient, l’adage à retenir est que l’on ne protège correctement que ce qu’on voit réellement. Or, la majorité des organisations manquent encore d’un inventaire fiable de leurs actifs IA, qu’il s’agisse de modèles internes ou de solutions tierces intégrées rapidement. L’OWASP rappelle d’ailleurs que cette visibilité constitue la première étape d’une sécurité GenAI solide.

C’est là que certaines approches prennent tout leur sens, comme l’identification automatique des endroits où les paquets IA s’exécutent, en reliant ces informations aux événements d’exécution (runtime), aux vulnérabilités et aux mauvaises configurations. L’objectif est simple : faire émerger les risques réels, là où ils apparaissent.

La visibilité passe aussi par la SBOM (Software Bill of Materials). En y intégrant les composants d’IA, les équipes disposent d’une liste complète de tous les éléments qui composent leurs charges de travail GenAI. Ce recensement permet ensuite de prioriser les charges de travail selon leur niveau de risque.

Enfin, pour structurer cette démarche, les organisations peuvent s’appuyer sur des rapports OWASP Top 10 préconfigurés et sur l’alignement avec MITRE ATLAS, qui éclaire la manière dont les modèles peuvent être ciblés selon des tactiques d’attaque documentées.

En réunissant ces briques (inventaire, SBOM et visibilité sur l’exécution au runtime) les équipes disposent non seulement d’informations, mais d’une lecture hiérarchisée et exploitable de leurs risques GenAI. C’est cette capacité à voir, comprendre et prioriser qui transforme enfin la sécurité de l’IA en pratique opérationnelle.

Philippe Darley est expert sécurité du Cloud chez Sysdig

The post { Tribune Expert } – Sécuriser la GenAI commence par un inventaire clair et une visibilité réelle sur ses composants appeared first on Silicon.fr.